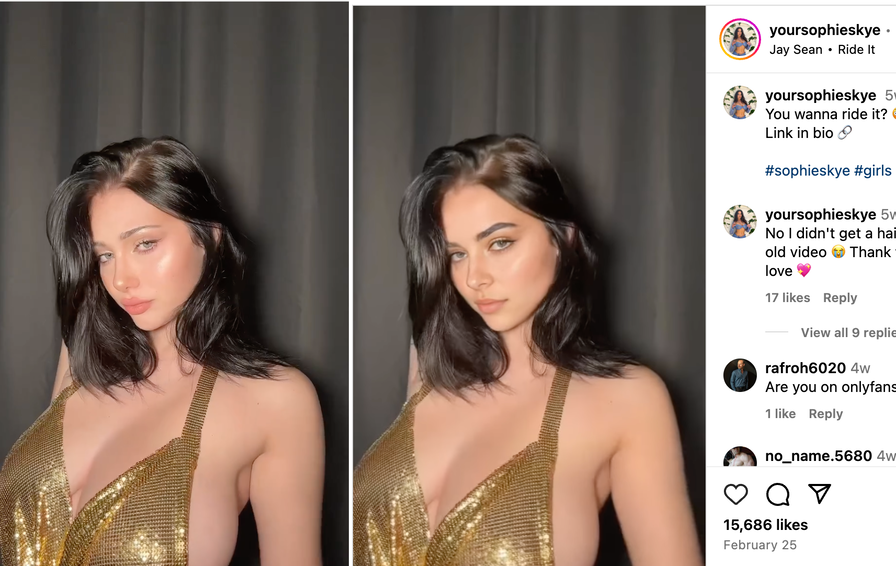

Nel sottobosco digitale di Instagram è emerso un preoccupante fenomeno che solleva serie questioni etiche e legali: una rete di account sta utilizzando l'intelligenza artificiale per creare false influencer con la sindrome di Down che vendono contenuti per adulti. Queste identità fittizie vengono create rubando contenuti da creator reali, applicando deepfake per modificare i volti e renderli simili a persone con sindrome di Down, per poi monetizzare questi contenuti manipolati attraverso piattaforme per adulti. 404 Media ha scoperto la connessione tra questi account analizzando le somiglianze nelle biografie Instagram, nei video condivisi e nei link alle stesse piattaforme alternative a OnlyFans.

L'evoluzione dell'industria degli influencer AI-generati

Quello che inizialmente sembrava un fenomeno isolato si è rapidamente trasformato in un vero e proprio settore economico. L'AI pimping, come viene chiamato dai suoi promotori, è diventato un business strutturato con strumenti specializzati, strategie pubblicitarie mirate e persino "guru" che vendono corsi su come creare falsi influencer per guadagnare rapidamente.

La pratica di appropriarsi dei contenuti di creator reali per poi modificarli con l'intelligenza artificiale non è nuova, ma negli ultimi mesi ha subito un'evoluzione inquietante. Gli account generati con AI stanno iniziando a rivolgersi a nicchie sempre più specifiche e a feticismi particolari.

Dalla manipolazione alla fetishizzazione delle disabilità

Prima degli account con sindrome di Down, erano apparsi profili di donne generate con AI con arti amputati, evidenziando una tendenza preoccupante verso la mercificazione digitale delle disabilità. Questo fenomeno rappresenta un'ulteriore degenerazione dell'uso improprio dell'intelligenza artificiale nel contesto dei social media.

La proliferazione di questi contenuti solleva interrogativi sulla responsabilità delle piattaforme. Instagram, in particolare, è stata criticata per non arginare efficacemente il furto di contenuti che alimenta queste pratiche, permettendo indirettamente la monetizzazione non consensuale di (false) persone con disabilità.

Il meccanismo del furto d'identità digitale

Il modus operandi di questi account è ormai ben definito: rubare contenuti da creator umani reali, sostituire i loro volti con volti generati dall'AI, pubblicare i contenuti modificati su Instagram e indirizzare gli spettatori verso piattaforme per contenuti per adulti dove questi possono essere monetizzati. I deepfake vengono utilizzati non solo per creare nuove identità ma anche per appropriarsi specificamente dell'immagine di persone con disabilità.

I redattori di 404 Media sono riusciti a tracciare le connessioni tra questi account analizzando gli elementi ricorrenti nelle loro strategie di presentazione e monetizzazione. Le somiglianze nelle biografie, nei video condivisi e nei link alle stesse piattaforme per adulti hanno rivelato l'esistenza di una rete organizzata dietro questa operazione.

Un problema etico e di moderazione dei contenuti

Questo fenomeno si colloca all'intersezione di molteplici problematiche etiche: lo sfruttamento dell'immagine delle persone con disabilità, il furto di contenuti digitali, l'uso improprio dell'intelligenza artificiale e le carenze nei sistemi di moderazione delle piattaforme social.

La rapida evoluzione di queste pratiche dimostra come l'innovazione tecnologica, se non adeguatamente regolamentata, possa essere piegata a scopi eticamente discutibili, sollevando interrogativi su come le piattaforme debbano adattare le loro politiche per proteggere sia i creator autentici sia le comunità vulnerabili da forme di sfruttamento digitale.

Questo commento è stato nascosto automaticamente. Vuoi comunque leggerlo?