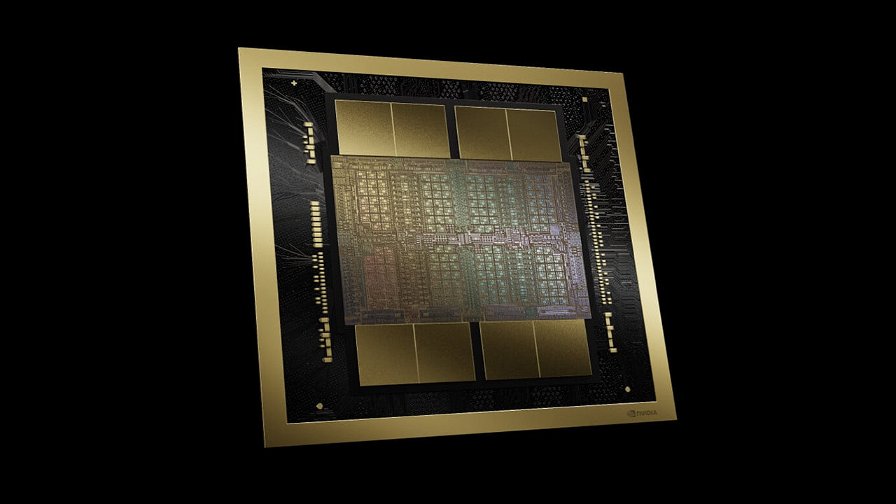

Uno studio pubblicato dell'Università della California, Santa Cruz, ha rivelato la scoperta di un modo per far funzionare i moderni modelli di linguaggio di grandi dimensioni (LLM) con soli 13 Watt di potenza. Per avere un valore di riferimento, parliamo all'incirca dello stesso consumo energetico di una lampadina LED da 100W equivalente. Al contempo si parla di una riduzione di 50 volte rispetto ai 700W di potenza necessari per alimentare le GPU per i data center come la Nvidia H100 e H200, senza contare la futura Blackwell B200 che può arrivare fino a 1200W per GPU.

I ricercatori hanno ottenuto questi risultati utilizzando hardware custom FGPA, chiarendo che la maggior parte dei guadagni in termini di efficienza può essere applicata tramite software open-source e ottimizzazioni degli attuali setup. La chiave di queste prestazioni elevate è stata la rimozione della matrice di moltiplicazione (MatMul) dai processi di addestramento e inferenza dei LLM.

Ma come hanno fatto a rimuovere la MatMul da una rete neurale mantenendo le stesse prestazioni e accuratezza? I ricercatori hanno combinato due metodi. Innanzitutto, hanno convertito il sistema numerico in un sistema "ternario" utilizzando -1, 0 e 1. Questo rende possibile il calcolo sommando piuttosto che moltiplicando i numeri. Successivamente, hanno introdotto il calcolo basato sul tempo nell'equazione, dando alla rete una sorta di "memoria" per permetterle di eseguire ancora più rapidamente con meno operazioni.

Il modello di riferimento utilizzato dai ricercatori è stato il LLM di Meta, LLaMa. L’ispirazione per il progetto è venuta da un paper di Microsoft sull’uso dei numeri ternari nelle reti neurali, anche se Microsoft non è arrivata a rimuovere la moltiplicazione della matrice o a rendere open-source il proprio modello come hanno fatto i ricercatori dell'UC Santa Cruz.

In sostanza, si tratta di un problema di ottimizzazione. Rui-Jie Zhu, uno dei ricercatori che ha lavorato al paper, ha spiegato:

"Abbiamo sostituito l'operazione costosa con operazioni più economiche". Resta da vedere se l'approccio possa essere applicato universalmente alle soluzioni AI e LLM, ma se fosse possibile, potrebbe cambiare radicalmente il panorama dell'AI.

Negli ultimi anni, abbiamo assistito a una crescente domanda di potenza dai principali aziende di IA. Questa ricerca suggerisce che gran parte di questo aumento è dovuto all'uso di metodi di elaborazione inefficienti. Figure autorevoli, come il CEO di Arm, avvertono che se la domanda di potenza dell'AI continua a crescere ai tassi attuali, potrebbe consumare un quarto dell'energia degli Stati Uniti entro il 2030. Ridurre l'utilizzo di potenza a un cinquantesimo dell’attuale quantità rappresenterebbe un miglioramento significativo.

Ci auguriamo che aziende come Meta, OpenAI, Google, Nvidia e altri grandi player trovino modi per sfruttare questa innovazione open-source. Un'elaborazione più veloce e molto più efficiente dei carichi di lavoro dell'IA ci avvicinerebbe a livelli di funzionalità simili al cervello umano(che consuma circa 0,3 kWh di potenza al giorno, circa 1/56 di ciò che richiede una Nvidia H100). Naturalmente, molti LLM richiedono decine di migliaia di queste GPU e mesi di addestramento, quindi il nostro cervello non è completamente sorpassato, almeno per ora.