Seagate, gigante del settore dei dispositivi di archiviazione dati, ha svelato la sua visione futuristica per gli hard disk destinati ai data center alimentati da intelligenza artificiale. In un ambiente in cui la necessità di memorizzazione dei dati sta crescendo esponenzialmente, questioni di costi, complessità e latenza rappresentano ostacoli significativi. Ma la soluzione di Seagate potrebbe offrire una risposta.

Le unità a stato solido possono fornire prestazioni ad alta velocità, ma il loro costo le rende insostenibili per lo stoccaggio a lungo termine su larga scala. Allo stesso tempo, gli hard disk basati su SATA e SAS, pur essendo più convenienti, comportano una complessità e una latenza significative a causa della loro dipendenza da adattatori di bus host (HBA), silicio proprietario e sistemi di controllo non adatti alle esigenze di alte prestazioni e bassa latenza dell'AI.

Le opzioni di archiviazione cloud presentano le loro complicazioni, tra cui alti costi di trasferimento dati WAN, tempi di recupero imprevedibili e spike di latenza, che ostacolano l'efficienza del processo delle operazioni dedicate alle AI.

La soluzione di Seagate prevede lo sviluppo di HDD che utilizzano PCIe, un'interfaccia comune, e il protocollo NVMe 2. Questa combinazione promette di offrire una larghezza di banda significativamente maggiore, una latenza inferiore e una migliore scalabilità rispetto a SATA/SAS. A differenza di questi ultimi, che sono limitati a velocità tra 6 e 12 Gbps e dipendono da strati complicati come gli HBA, NVMe funziona su un'interfaccia PCIe standard del settore, supportando velocità fino a 128 GB/s.

Da teoria a pratica: il sistema di prova

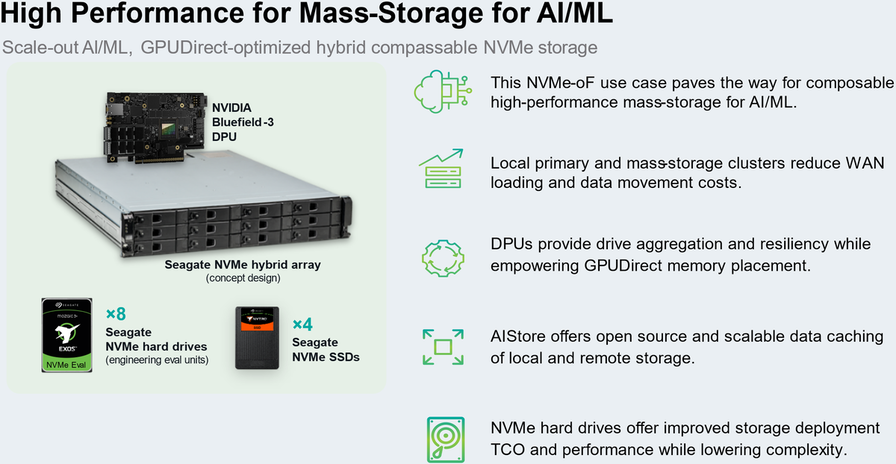

In una dimostrazione alla recente conferenza GTC, Seagate ha presentato un sistema di prova che dimostra come la tecnologia NVMe può trasformare gli hard drive per il carico di lavoro AI. Questo sistema era composto da hard drive NVMe, SSD NVMe, l'unità di elaborazione dei dati (DPU) BlueField 3 di Nvidia e il software AIStore.

Il test rivelò che l'accesso diretto della GPU allo storage minimizzava la latenza nei flussi di lavoro AI. Inoltre, la rimozione dell'infrastruttura SAS/SATA ridurrebbe la complessità del sistema e migliorerebbe l'efficienza dello storage. Il software AIStore ottimizza dinamicamente la memorizzazione nella cache e la scelta dei livelli, migliorando notevolmente le prestazioni nell'addestramento dei modelli AI. Seagate ritiene anche possibile scalare il sistema a livelli di esabyte utilizzando NVMe-over-Fabric (NVMe-oF), permettendo un'espansione senza soluzione di continuità dei cluster di storage AI su multi-rack.

Il conseguimento di quest'obiettivo potrebbe permettere ai data center ad alte prestazioni di supportare ambienti AI senza affidarsi completamente a soluzioni di storage interamente flash, mantenendo le prestazioni ma riducendo al contempo i costi.

Quando assisteremo a questi cambiamenti?

Per quanto entusiasmanti, queste prospettive sollevano una domanda inevitabile: quando questi hard disk NVMe saranno effettivamente disponibili sul mercato? Nonostante Seagate sia in vantaggio rispetto ai suoi concorrenti, gran parte dell'industria preferisce disporre di una doppia fonte di approvvigionamento per prodotti come gli HDD.

Per questo, l'adozione su larga scala di hard disk NVMe potrebbe richiedere un po' di tempo in più. Ma una cosa è certa: una volta che tutto l'ecosistema sarà pronto, i fornitori di servizi cloud che servono aziende e carichi di lavoro AI saranno pronti per adottare queste nuove tecnologie.

Infine, è importante notare che con l'aumento della capacità degli HDD, le prestazioni IOPS per terabyte tendono a diminuire. Questo potrebbe avere un impatto sulle prestazioni nei cluster AI in futuro e potrebbe richiedere un maggior uso di flash per mitigarlo. Forse, man mano che la complessità dell'AI aumenta, si potrebbe assistere all'adozione di HDD dual-actuator come il Mach.2 di Seagate, più costosi dei comuni HDD a singolo attuatore ma ancora molo conveniente rispetto a due HDD a singolo attuatore. Questo potrebbe rappresentare un'altra possibile rivoluzione per l'archiviazione nei data center AI.

Perchè non usare quest'ultimo ma inventarsi da zero un nuovo standard?

Questo commento è stato nascosto automaticamente. Vuoi comunque leggerlo?