Durante il keynote tenuto da Jensen Huang nel corso del COMPUTEX, NVIDIA si è concentrata molto sull’intelligenza artificiale, sui chip per data center (per cui ha annunciato che ci sarà una nuova architettura ogni anno, la prossima sarà Rubin) e sui nuovi “umani digitali”. Dietro le quinte l’azienda ha però mostrato anche alcune novità tecnologiche per il settore consumer, presentandoci delle demo molto interessanti.

A catturare maggiormente il nostro interesse è stata la nuova demo di NVIDIA ACE, che ha fatto ulteriori passi in avanti rispetto a quelle provate in precedenza. La demo include quattro tecnologie IA: il riconoscimento della voce, la trasformazione dell’input vocale in testo, la creazione di una risposta tramite LLM e NVIDIA Audio2Face, per le animazioni facciali dei personaggi.

Nella demo ci troviamo nella hall di un hotel e il nostro obiettivo è quello di scoprire il numero di camera di un ospite. Possiamo parlare con diversi personaggi, ognuno con i propri tratti di personalità e il proprio background (elementi che gli sviluppatori possono definire facilmente tramite software), che si approcceranno a noi in modo diverso: il portiere è un chiacchierone, la receptionist è estremamente professionale, mentre un collega dell’ospite che stiamo cercando sembra parecchio seccato dalla nostra presenza. L’interazione è estremamente naturale e, ve lo assicuro, non è semplice raggiungere l’obiettivo.

Un aspetto davvero fenomenale della tecnologia è il suo supporto multi lingua: avevo già provato questa demo qualche mese fa, ma a differenza della primissima demo di ACE vista in occasione del CES di Las Vegas, dove parlavamo con un barista, qui era disponibile solo l’inglese. Ora invece sono stati fatti passi avanti e il riconoscimento vocale supporta qualsiasi lingua: ho fatto delle prove parlando in italiano, il modello ha capito perfettamente le mie frasi, le ha tradotte in inglese (mostrato i sottotitoli del mio personaggio in inglese) e ho ricevuto risposte in inglese dagli NPC. In futuro, l’implementazione nei giochi sarà esattamente come la demo del bar: potremo parlare in qualsiasi lingua, l’IA la capirà e l’NPC ci risponderà nella stessa lingua.

Era presente anche una seconda demo di ACE, creata in collaborazione con Perfect World, che sfruttava un modello bilingue: qui era possibile parlare con l’NPC in inglese o in mandarino, ricevendo risposta vocale nella medesima lingua e scritta in quella opposta. Per farvi capire meglio: parlando in inglese, il personaggio ci rispondeva in inglese, ma tutti i sottotitoli erano in cinese mandarino.

Altra demo che è finita sotto i riflettori è quella di G-Assist, l’assistenza IA per i videogiochi. Lo abbiamo visto in azione su Ark: Survival Evolved e ha sorpreso parecchio: si basa su due modelli IA, uno che esegue un OCR per leggere il testo a schermo, l’altro che scansiona tutto quello che c’è a schermo per identificare la situazione e avere contesto (è in grado, ad esempio, di riconoscere i dinosauri, le icone, e così via).

Anche qui ci interfacciamo con l’assistente tramite input vocale o di testo, possiamo chiedergli per esempio qual è il dinosauro che abbiamo di fronte, oppure, aprendo l’inventario, se abbiamo tutto quello che ci serve per addomesticarlo. L'assistente funziona come una sorta di wiki, rispondendo alle nostre domande e dandoci indicazioni.

G-Assist però va oltre gli aiuti in gioco: può anche agire sul sistema ottimizzando le prestazioni, interpretando gli input in linguaggio naturale. Possiamo chiedergli ad esempio di ottimizzare l’efficienza ma mantenerci sopra i 60 FPS, oppure di spingere la scheda al massimo delle prestazioni. L’assistente agirà di conseguenza, modificando la frequenza operativa della GPU (non effettua, al momento, operazioni come l’undervolt), assicurandosi al tempo stesso che il sistema rimanga stabile. In questo modo, chiunque, anche i meno esperti, potranno ottenere il massimo dal proprio computer, che vogliano il massimo degli FPS, o un sistema più silenzioso.

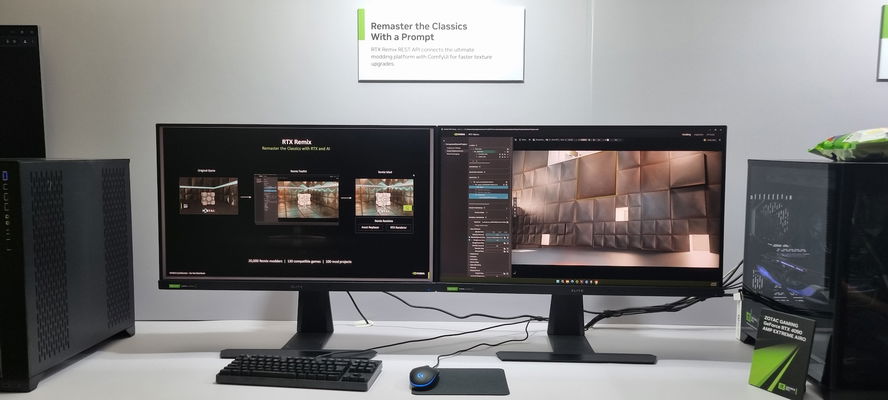

Non sono mancate le novità anche per altre tecnologie già note: in RTX Remix ci sono nuove impostazioni per le texture, Chat RTX supporta più modelli di linguaggio, l’app NVIDIA ora integra un pannello per l’ottimizzazione automatica della GPU e permette di registrare a 120fps con codec AV1.

Per i creatori di contenuti, NVIDIA ha mostrato le potenzialità del doppio encoder (presente sulle GPU di fascia più alta) con Capcut, dove riduce di molto il tempo di rendering, l’integrazione dell’IA in DaVinci Resolve per l’upscale dei contenuti (da 480p e 1080p a 1080p e 4K) e per la trasformazione dei contenuti SDR in HDR e novità per Topaz Photo AI, che ora sfrutta i Tensor Core NVIDIA per rimuovere il rumore e gli oggetti indesiderati dalle immagini ancora più velocemente e con maggior precisione.

Insomma, NVIDIA aveva parecchia carne al fuoco, anche se come detto le demo più interessanti riguardavano ACE e G-Assist che, purtroppo, non sappiamo quando arriverà. Inutile dire che la speranza è di vedere queste tecnologie implementate quanto prima nei videogiochi: vi immaginate la possibilità di avvicinarsi a un NPC, parlargli e ricevere una risposta? Si tratta di qualcosa che porterà l’immersività a un livello completamente nuovo.