Microsoft ha presentato Maia 100, il suo primo chip IA specializzato, alla conferenza Hot Chips 2024. Il processore, realizzato con tecnologia TSMC a 5 nm, è progettato per migliorare le prestazioni e ridurre i costi dei servizi IA avanzati come Azure OpenAI.

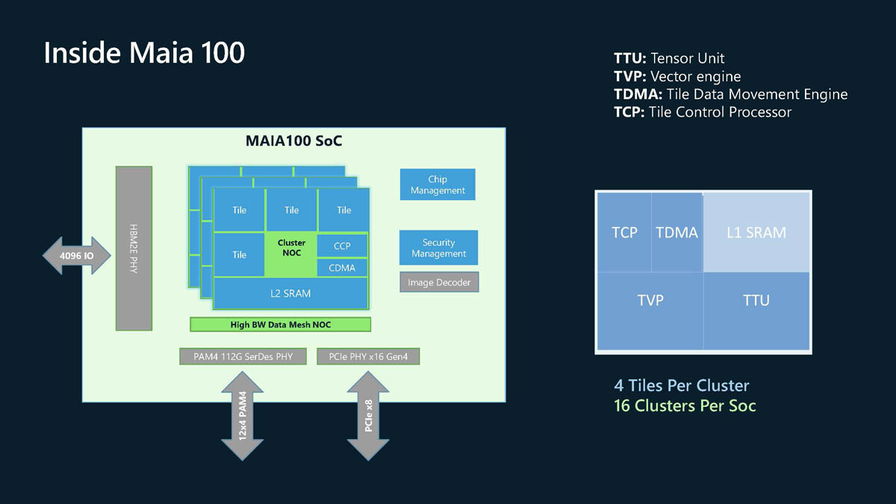

Maia 100 si distingue per la sua architettura integrata che comprende schede server personalizzate, rack dedicati e un sistema software ottimizzato. Il chip vanta una unità tensor ad alta velocità per l'elaborazione rapida di compiti di training e inferenza, supportando vari formati di dati incluso il nuovo formato MX introdotto da Microsoft nel 2023.

Tra le caratteristiche principali di Maia 100 troviamo:

- Un processore vettoriale con architettura personalizzata

- Un motore DMA per lo sharding dei tensori

- Semafori hardware per la programmazione asincrona

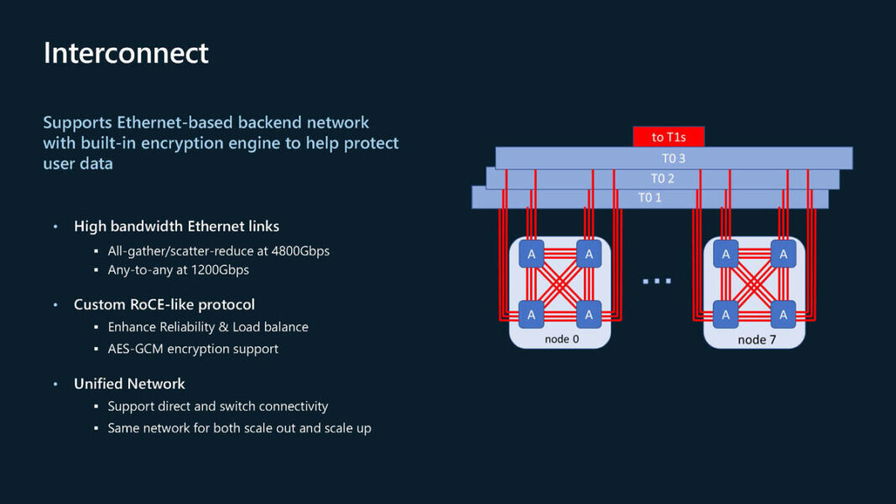

- Connettività di rete basata su Ethernet con protocollo simile a RoCE

Specifiche tecniche

Il chip Maia 100 ha dimensioni di 820 mm² e un TDP di progetto di 700 W (500 W provvisorio). Utilizza memoria HBM2E con una larghezza di banda di 1,8 TB/s e una capacità di 64 GB. Le prestazioni di picco arrivano a 3 POPS per operazioni a 6 bit.

Microsoft ha anche sviluppato un SDK dedicato per facilitare l'adattamento di modelli PyTorch e Triton su Maia. Gli sviluppatori possono programmare il sistema utilizzando il linguaggio Triton o le API Maia proprietarie per un controllo più granulare.

Resta da vedere se Microsoft deciderà di rendere gli acceleratori Maia 100 accessibili ad altre organizzazioni, seguendo l'esempio di Google e Amazon con i loro chip IA. Per ora, l'azienda sembra focalizzata sull'utilizzo interno per potenziare i propri servizi cloud IA.