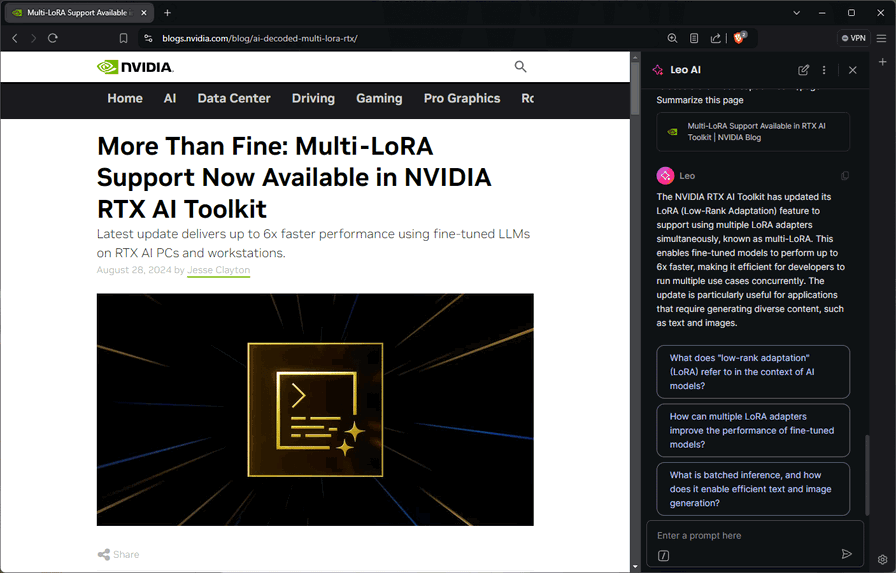

Il popolare browser Brave, incentrato sulla privacy, ha lanciato un nuovo assistente AI chiamato Leo AI. Si tratta di un'intelligenza artificiale capace di riassumere articoli e video, estrarre informazioni da documenti e rispondere a domande degli utenti, migliorando l'esperienza di navigazione.

Una delle particolarità di Leo AI è la sua capacità di funzionare anche in locale, sfruttando la potenza delle GPU NVIDIA RTX e dei loro Tensor Core, ottimizzati per i carichi di lavoro IA.

Il ruolo cruciale del software

Sebbene l'hardware sia fondamentale, il software gioca un ruolo altrettanto importante nel garantire prestazioni AI ottimali. Leo AI utilizza la libreria open source llama.cpp, che sfrutta l'API CUDA di NVIDIA per accelerare centinaia di modelli di linguaggio su GPU RTX. Sopra llama.cpp, Brave impiega Ollama come server di inferenza locale per semplificare l'integrazione dei modelli AI.

Vantaggi dell'elaborazione locale

L'esecuzione locale dei modelli AI offre diversi benefici rispetto al cloud:

- Maggiore privacy, senza invio di dati a server esterni;

- Disponibilità costante, anche offline;

- Nessun costo per l'accesso illimitato;

- Possibilità di utilizzare una varietà più ampia di modelli open source.

Inoltre, grazie all'accelerazione RTX, in locale è possibile generare fino a 110 parole al secondo usando il modello Llama 3 8B.

Come iniziare con Brave, Leo AI e Ollama

Per installare Ollama è sufficiente scaricare l'installer dal sito ufficiale. Una volta configurato Brave per utilizzare Ollama, Leo AI sfrutterà automaticamente i modelli AI locali per elaborare richieste e query. Gli utenti possono anche passare facilmente tra modelli cloud e locali in qualsiasi momento.