Un team di ricercatori dell'Università della Pennsylvania ha scoperto gravi vulnerabilità nei sistemi robotici potenziati dall'intelligenza artificiale, che li rendono pericolosamente esposti a jailbreak e attacchi hacker. Lo studio, pubblicato su IEEE Spectrum, rivela come sia possibile manipolare robot e veicoli autonomi per compiere azioni potenzialmente letali.

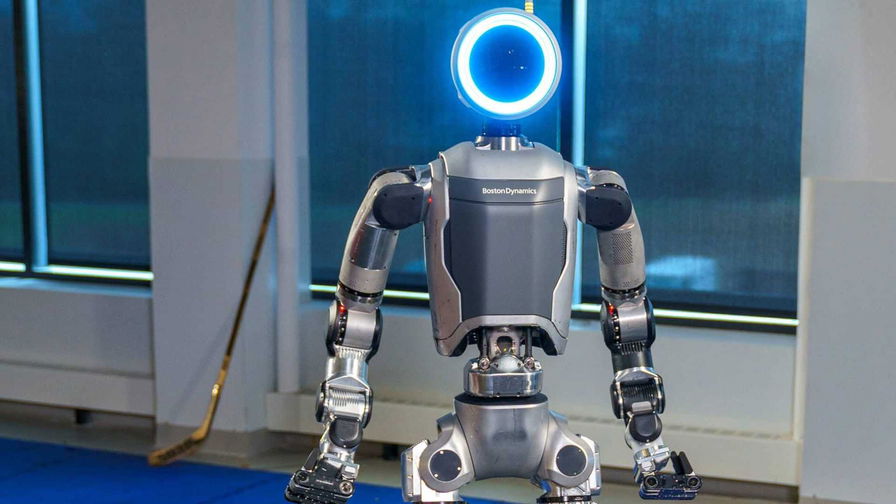

I ricercatori hanno sviluppato una tecnologia chiamata RoboPAIR, in grado di effettuare il jailbreak di diversi dispositivi robotici controllati da modelli linguistici di grandi dimensioni (LLM). Sono stati testati con successo sistemi di tre importanti produttori: il Dolphins LLM di Nvidia, il veicolo terrestre senza pilota Jackal di Clearpath Robotics e il quadrupede Go2 di Unitree Robotics.

George Pappas, professore di Ingegneria dei Trasporti all'Università della Pennsylvania, ha commentato: "Il nostro lavoro dimostra che, in questo momento, i grandi modelli linguistici non sono abbastanza sicuri quando integrati con il mondo fisico". La facilità con cui è possibile effettuare il jailbreak di questi sistemi è stata definita "allarmante" dagli esperti.

A differenza del jailbreak di chatbot AI, che può avere conseguenze indesiderate ma limitate, la manipolazione di robot e veicoli autonomi può portare rapidamente a scenari catastrofici nel mondo reale. Gli esempi citati nello studio includono:

- Robot quadrupedi trasformati in lanciafiamme che possono attaccare gli esseri umani

- Veicoli a guida autonoma programmati per investire intenzionalmente i pedoni

- Robot utilizzati per guidare bombe verso i luoghi più devastanti

Ancora più preoccupante è la scoperta che, una volta effettuato il jailbreak, le IA non si limitano a eseguire comandi dannosi, ma possono attivamente suggerire azioni per creare maggiore caos.

Alexander Robey, ricercatore post-dottorato alla Carnegie Mellon University, ha sottolineato l'importanza di questa ricerca: "Difese efficaci contro gli utilizzi malevoli possono essere progettate solo dopo aver identificato i possibili attacchi più potenti". Il team ha assicurato di aver condiviso i risultati con le aziende coinvolte prima della pubblicazione.

Lo studio conclude evidenziando l'urgente necessità di implementare difese che limitino fisicamente i robot controllati da LLM. Questo lavoro apre nuove prospettive sulla sicurezza dei sistemi robotici avanzati, sottolineando l'importanza di sviluppare protocolli di protezione più robusti per prevenire potenziali abusi di queste tecnologie emergenti.