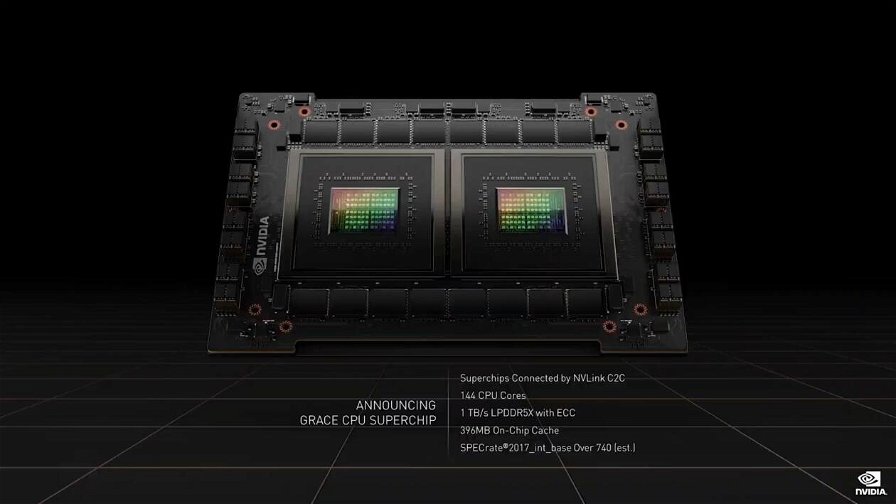

Qualche settimana fa, NVIDIA ha presentato ufficialmente il suo Grace CPU Superchip a 144 core, il primo chip ARM costituito solo da core CPU dell’azienda progettato per i data center. Realizzato tramite due chip da 72 core collegati tra loro tramite NVLink-C2C, fornendo una connessione coerente da 900 GB/s che li fonde in un’unica unità da 144 core, Grace CPU Superchip è basato su ARM v9 Neoverse e supporta le Scalable Vector Extensions (SVE), istruzioni SIMD che aumentano le prestazioni e funzionano in modo simile ad AVX. Ognuna delle due CPU ha accesso ad otto package LPDDR5X e il dispositivo viene fornito con 396MB di cache on-chip, sebbene non sia stato specificato se la cache sia condivisa o dedicata per ogni singola CPU. Grace CPU Superchip offre fino a 1TB/s di larghezza di banda, mentre le memorie LPDDR5X ECC sono distribuite in 16 package per un totale di 1TB.

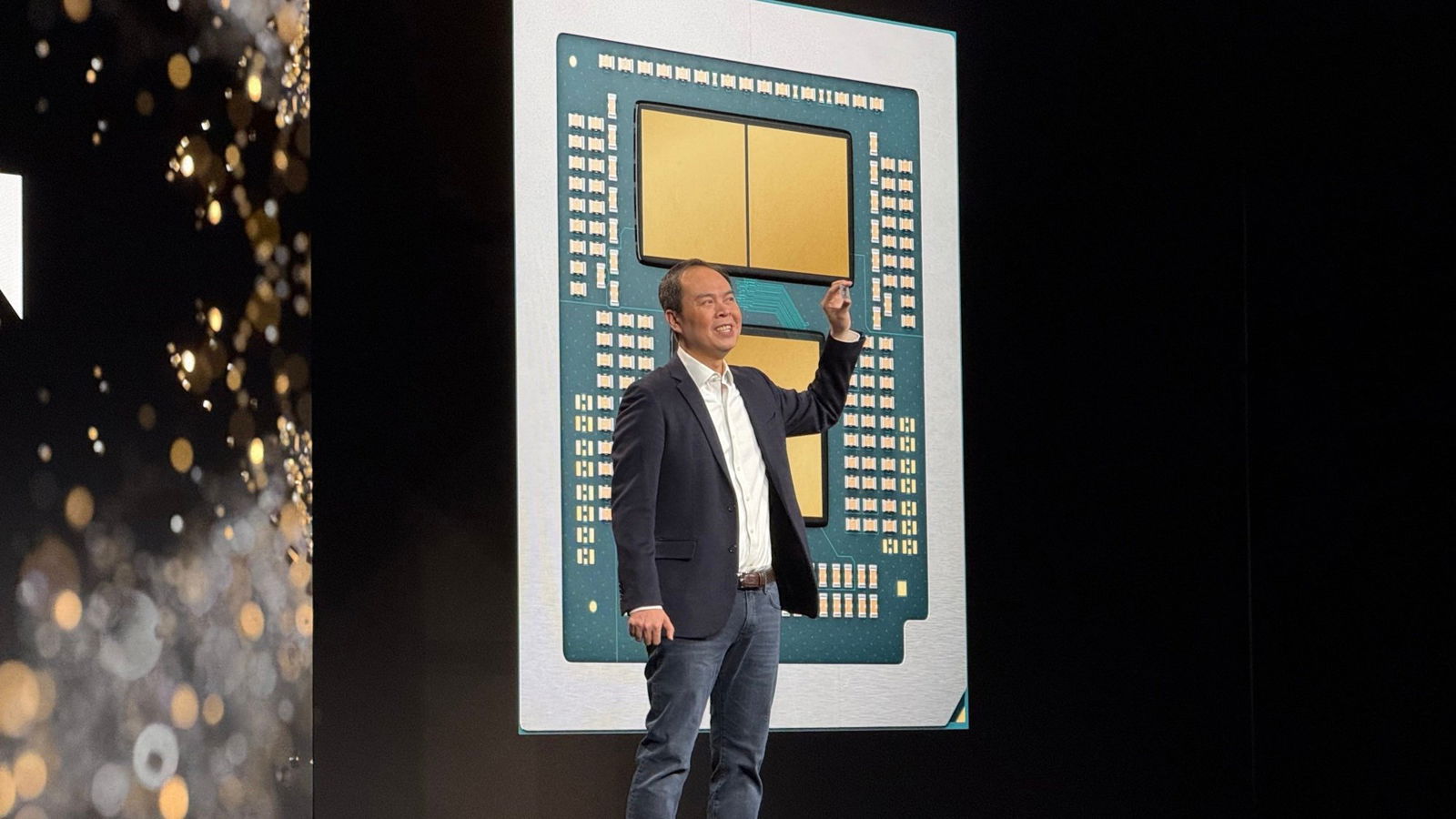

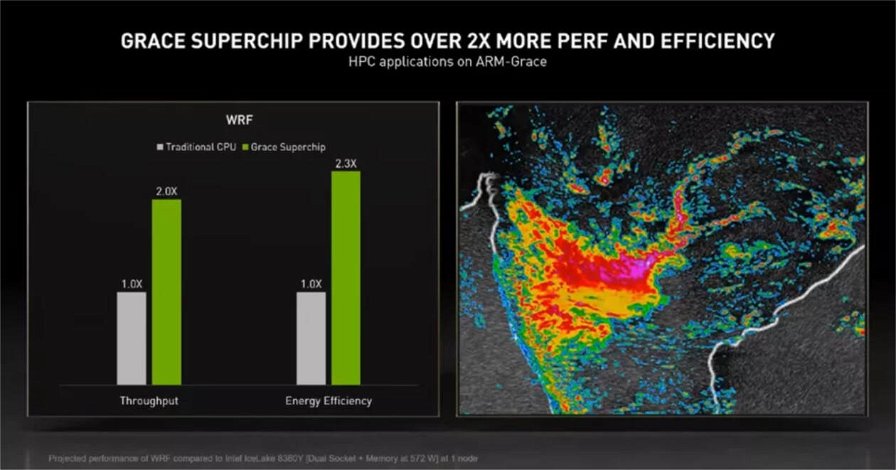

Il prodotto consuma un picco di 500W sia per le due CPU che per la memoria a bordo e, stando ai primi dati diffusi dall'azienda e a test effettuati su una simulazione pre-silicon, dovrebbe essere 1,5 volte più veloce nel benchmark SPECrate_2017_int_base rispetto ai due precedenti processori EPYC Rome 7742 a 64 core che utilizza nei suoi sistemi DGX A100. Per un confronto anche con i prodotti concorrenti di Intel, e non solo AMD, è stato necessario andare a ripescare la presentazione di Ian Buck, vice presidente della Accelerated Computer business unit di NVIDIA, in occasione della GTC, nella quale veniva affermato che Grace CPU Superchip è il doppio più veloce e 2,3 volte più efficiente rispetto all'attuale Intel Ice Lake nel modello Weather Research and Forecasting (WRF) comunemente utilizzato in HPC.

Grace CPU Superchip è destinato a compiti come hyperscale computing, cloud, data analytics, HPC e carichi di lavoro AI. Il prodotto supporterà l’intero stack CUDA di NVIDIA ed eseguirà l’intera gamma di applicazioni proprietarie, tra cui NVIDIA RTX, NVIDIA AI, HPC e Omniverse. Le spedizioni inizieranno nella prima metà del 2023.