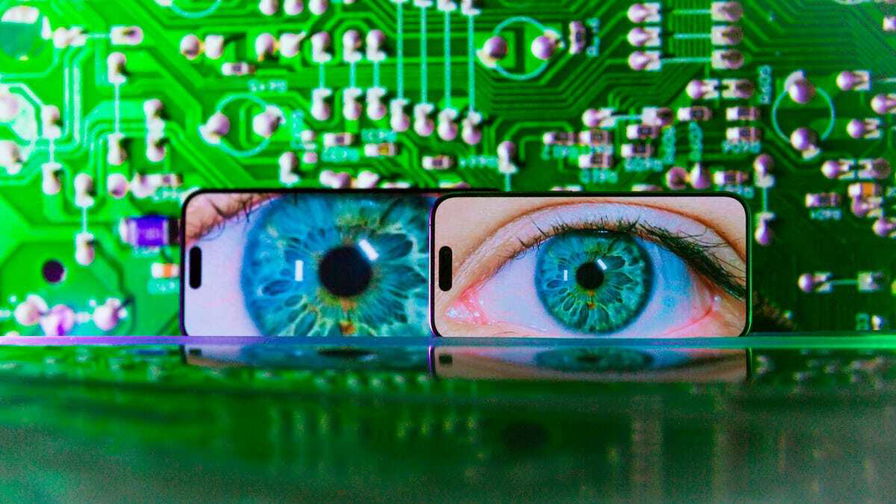

L'intelligenza artificiale potrebbe creare maschere digitali per proteggere le foto personali dai criminali informatici. Un nuovo studio dell'Università Georgia Tech, pubblicato il 19 luglio sul database arXiv, descrive, infatti, un modello di IA chiamato "Chameleon" in grado di generare una "maschera di protezione della privacy personalizzata" per le foto personali.

Questa maschera è in grado di ingannare i software di riconoscimento facciale non autorizzati, facendo riconoscere la foto come appartenente a un'altra persona, senza però compromettere la qualità dell'immagine originale. L'obiettivo è proteggere le foto dai criminali informatici che potrebbero utilizzarle per truffe, frodi o stalking.

Il professor Ling Liu, autore principale dello studio, ha dichiarato:

"La condivisione e l'analisi dei dati che preservano la privacy, come Chameleon, contribuiranno a promuovere una governance e un'adozione responsabile della tecnologia IA e stimoleranno una scienza e un'innovazione responsabili".

Il sistema Chameleon si basa su tre caratteristiche principali:

- Ottimizzazione tra immagini: crea una sola maschera per utente invece di una nuova per ogni foto, consentendo una protezione istantanea e un uso efficiente delle risorse di calcolo.

- Ottimizzazione della percettibilità: garantisce che la qualità visiva dell'immagine protetta sia preservata, senza interventi manuali.

- Robustezza: la maschera è progettata per ingannare anche modelli di riconoscimento facciale sconosciuti, grazie all'uso di tecniche di ensemble learning.

I ricercatori mirano ad applicare le tecniche di offuscamento di Chameleon oltre la protezione delle immagini personali individuali. Tiansheng Huang, dottorando della Georgia Tech coinvolto nello sviluppo di Chameleon, ha affermato: "Vorremmo utilizzare queste tecniche per proteggere le immagini dall'essere utilizzate per addestrare modelli generativi di intelligenza artificiale. Potremmo proteggere le informazioni delle immagini dall'essere utilizzate senza consenso".

L'obiettivo finale è trovare un equilibrio tra la protezione della privacy individuale e l'utilizzo etico dei dati per lo sviluppo di tecnologie IA, garantendo al contempo che le immagini personali non vengano sfruttate in modo improprio da attori malintenzionati o sistemi automatizzati non autorizzati.

Una curiosità interessante riguarda il nome scelto per il modello di IA descritto nello studio: "Chameleon". Il camaleonte è noto per la sua capacità di cambiare colore per mimetizzarsi nell'ambiente circostante, una caratteristica che riflette perfettamente l'obiettivo di questo sistema di protezione delle immagini. Come il camaleonte si adatta all'ambiente per sfuggire ai predatori, così Chameleon adatta l'immagine per sfuggire ai software di riconoscimento facciale non autorizzati.

Un altro aspetto affascinante di questa tecnologia è il suo potenziale impatto sul futuro dell'arte digitale. Gli artisti potrebbero utilizzare sistemi simili a Chameleon per creare opere che cambiano aspetto in base a chi le osserva o al contesto in cui vengono visualizzate, aprendo nuove frontiere nell'arte interattiva e nella protezione del copyright delle opere digitali.

Infine, è interessante notare come questa tecnologia si inserisca nel più ampio dibattito etico sull'uso dell'intelligenza artificiale. La sfida di bilanciare l'innovazione tecnologica con la protezione dei diritti individuali è un tema centrale nella società contemporanea, e sistemi come Chameleon rappresentano un passo importante verso una governance responsabile dell'IA.