AMD ha annunciato che il suo acceleratore AI di punta, MI325X, verrà migliorato in termini di larghezza di banda prima del suo lancio, previsto più avanti durante il corso dell'anno.

Questa dichiarazione è giunta in concomitanza con la notizia che AMD ha deciso di allinearsi alla metodologia di Nvidia, adottando una cadenza di rilascio annuale per la sua gamma di acceleratori "Instinct".

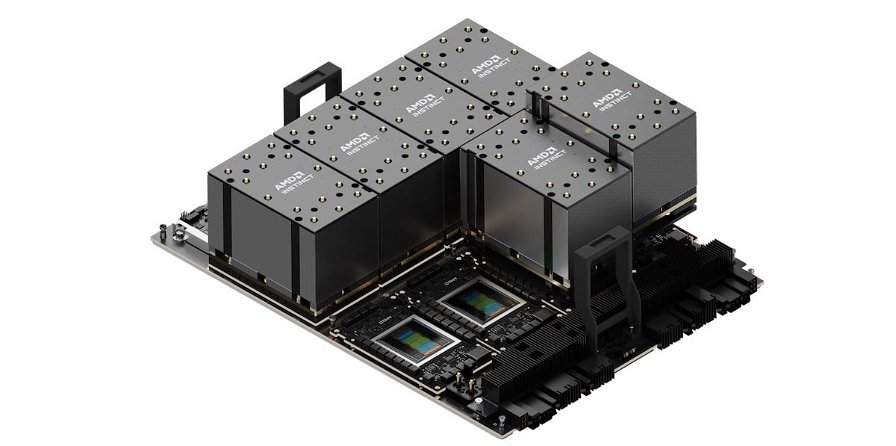

Il nuovo Instinct MI325X sembra, difatti, avere molte somiglianze con il dispositivo H200 di Nvidia, beneficiando anch'esso della tecnologia HBM3e. Il dispositivo è composto da otto chip di calcolo, quattro di I/O e otto chip di memoria, collegati tramite tecnologie di packaging 2.5D e 3D.

Le prestazioni del chip MI325X in termini di FLOPS sembrano rimanere invariate rispetto alle versioni precedenti, raggiungendo 1.3 petaFLOPS in BF/FP16, o 2.6 petaFLOPS in FP8.

AMD, infatti, sembrerebbe concentrarsi maggiormente sulla memoria, volendo superare Nvidia in termini di capacità. Con 288GB, il MI325X contiene più del doppio della memoria HBM3 dell’H200 e il 50% in più rispetto ai chip Blackwell di Nvidia.

La transizione all'HBM3e migliora anche la larghezza di banda della memoria dell'MI325X a 6TB/sec, un aumento significativo rispetto ai 5.3TB/sec del MI300X e 1,3 volte superiore all'H200. Tuttavia, questa larghezza di banda è considerata ancora distante dai 8TB/sec visti nei GPU Blackwell di Nvidia.

Si discute anche del supporto della memoria necessaria per l'inferenza AI. Con il MI325X, si prevede di gestire modelli con 1 trilione di parametri, tuttavia AMD ha accentuato le prestazioni in FP16, che richiede il doppio della memoria per parametro rispetto a FP8, il che potrebbe ridurre i vantaggi della sua elevata capacità di memoria.

Anche se la tecnologia supporta FP8, AMD ha evidenziato i benchmark principalmente in FP16 per via della mancanza di un supporto solido per i datatype FP8 nella libreria di inferenza vLLM.

Ciò impedisce al MI300X, e presumibilmente anche al MI325X, di ottenere il massimo dalle loro capacità in termini di inferenza in FP8.

AMD ha, inoltre, anticipato alcune future migliorie per il successore del MI325X, le quali includeranno l'architettura CDNA 4, che continuerà a utilizzare la configurazione di 288GB di HBM3e e si sposterà su un nodo di processo a 3nm. Sarà anche aggiunto il supporto per i dati FP4 e FP6, che dovrebbero aiutare a superare alcune delle sfide attuali legate a FP8.

Nel 2025, con l'introduzione di "CDNA next", AMD promette un significativo aggiornamento architettonico che potrebbe includere implementazioni multi-die eterogenee o l'estensione della memoria fotonica, grazie anche all'investimento in innovazioni come quelle proposte da Celestial AI.