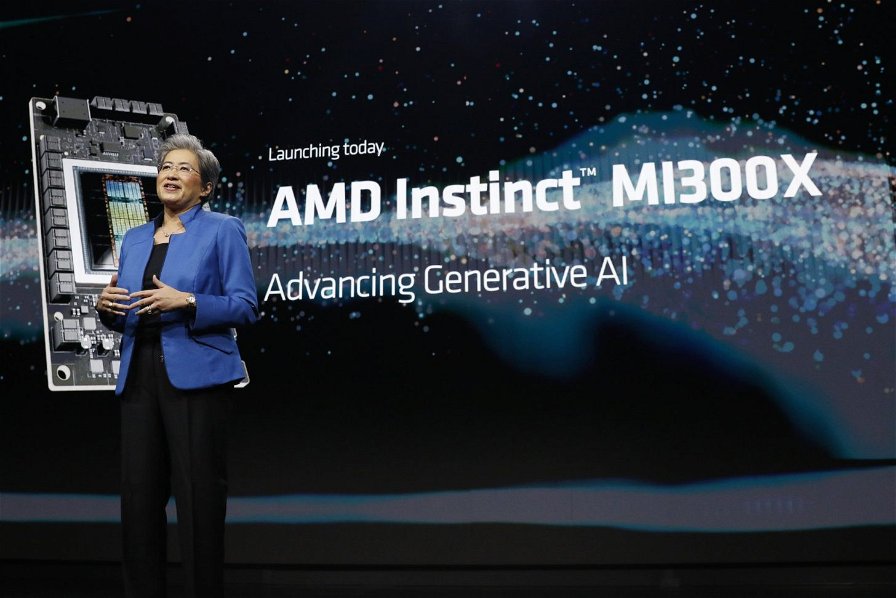

AMD ha rivelato il suo nuovo e potente acceleratore GPU per l'intelligenza artificiale, il MI300X, presentando prestazioni superiori fino al 60% rispetto al suo concorrente diretto, l'H100 di NVIDIA.

L'AMD Instinct MI300, appartenente alla classe degli acceleratori AI, si basa su chiplet di grande potenza, sfruttando avanzate tecnologie di packaging provenienti da TSMC.

Il lancio di questi chip è stato accompagnato dai primi risultati dei benchmark del MI300X, che hanno suscitato notevole interesse. Le specifiche iniziali confrontate con l'H100 di NVIDIA per il loro acceleratore CDNA 3 mostrano significativi vantaggi:

- Capacità di memoria 2,4 volte superiore

- Banda di memoria 1,6 volte più ampia

- Prestazioni FP8 TFLOPS 1,3 volte superiori

- Prestazioni FP16 TFLOPS 1,3 volte superiori

- Velocità fino al 20% superiore nell'esecuzione di Llama 2 70B e FlashAttention 2 in confronti 1v1

- Incrementi fino al 40% e 60% rispettivamente nell'esecuzione di Llama 2 70B e Bloom 176B in configurazioni server 8v8

Nei TFLOPs del kernel LLM, il MI300X dimostra un vantaggio fino al 20% nelle esecuzioni di FlashAttention-2 e Llama 2 70B. La piattaforma 8x MI300X supera l'H100 di NVIDIA con un guadagno più significativo del 40% in Llama 2 70B e del 60% in Bloom 176B.

AMD ha evidenziato che il MI300X offre prestazioni di addestramento paragonabili alla concorrenza (H100), fornendo un ottimo rapporto qualità-prezzo, in particolare nelle attività di inferenza.

L'innovazione trainante dietro questi acceleratori MI300 è ROCm 6.0, che comprende supporto per svariati carichi di lavoro di intelligenza artificiale come AI generativa e grandi modelli linguistici.

Il nuovo stack software offre supporto per formati di calcolo recenti come FP16, Bf16 e FP8, offrendo miglioramenti fino a 2,6x nelle prestazioni vLLM grazie a librerie di inferenza ottimizzate.

Il MI300X è il chip protagonista, progettato esclusivamente sull'architettura CDNA 3 e incorporante IP a 5 nm e 6 nm, raggiungendo un totale di 153 miliardi di transistor. Il design include un interposer principale con 28 die, otto pacchetti HBM3 e quattro die attivi, con ognuno che ospita due die di calcolo.

Ogni GCD basato su GPU CDNA 3 presenta 40 unità di calcolo, totalizzando 320 unità di calcolo e 20.480 core. La memoria HBM3 del MI300X è aumentata del 50% rispetto al MI250X, raggiungendo una capacità di 192 GB, fornendo una banda fino a 5,3 TB/s e una banda Infinity Fabric di 896 GB/s.

Rispetto alla concorrenza, l'AMD Instinct MI300X è classificato a 750 W, segnando un aumento del 50% rispetto al MI250X e 50 W in più rispetto all'H200 di NVIDIA. Le soluzioni server mostrate includono sistemi di Gigabyte con 8 acceleratori GPU MI300X e due CPU AMD EPYC 9004, evidenziando vantaggi significativi rispetto alle piattaforme NVIDIA HGX H100.

AMD deve confrontarsi con la concorrenza, con NVIDIA che punta a rilasciare le GPU Hopper H200 e Blackwell B100 nel 2024, mentre Intel prepara i suoi Gaudi 3 e Falcon Shores. Tuttavia, aziende come Oracle, Dell, META e OpenAI hanno già annunciato il supporto per i chip AI Instinct MI300 di AMD.