La questione etica si pone probabilmente per ogni avanzamento tecnologico ma con l’AI è più rilevante, per il semplice fatto che l’impatto in termini di fare del bene o di fare del male e qualcosa che, probabilmente, nessuna tecnologia ha mai avuto prima nella storia dell’umanità.

Per trovare un’analogia il più semplice possibile, nella produzione di pistole non si pongono molte questioni etiche: si tratta di produrle o di non produrle. Eventuali pensieri sono poi delegati alla distribuzione e all’utilizzo del prodotto finito, ma non c’è molto che il produttore possa fare a parte appunto, forse, fermare tutto e dedicarsi alla floricoltura.

Con le AI invece ci si domanda come produrle affinché siano eticamente accettabili. Certo, la prima e più naturale obiezione potrebbe essere che lo strumento è neutro di per sé, e che sono le persone a farne un uso etico-morale. Ed è verissimo, tuttavia proprio l’uso di regole e principi ex-ante è ciò di cui abbiamo bisogno per assicurarsi che l’AI sia usata in modo etico, andando a prevenire sia azioni negative volontarie sia gli incidenti.

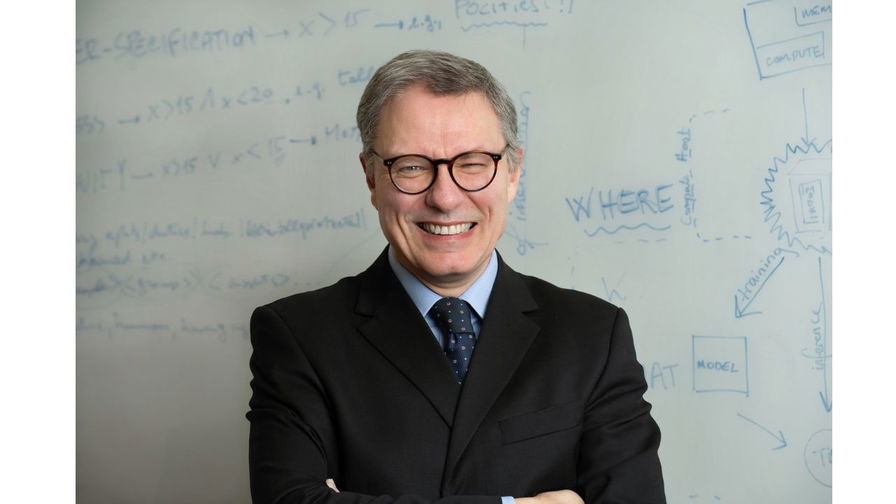

Luciano Floridi, tra i filosofi contemporanei più autorevoli nel campo dell’etica digitale, lo dimostra con chiarezza nel suo libro Etica dell’intelligenza artificiale, dove propone una riflessione articolata che tocca la responsabilità giuridica, la giustizia sociale, la sostenibilità ambientale e le modalità con cui vengono progettati e regolati i sistemi intelligenti. Il libro è uscito nel 2022, eppure ancora oggi offre una visione incisiva, tagliente e precisa.

Tutti quelli che si occupano di AI, da chi la sviluppa a chi la usa, dovrebbero leggere questo libro. Ma non è una lettura facile: è un testo di filosofia ed è un testo accademico per davvero, con un sacco di note bibliografiche e di rimandi ad altre opere. Floridi sceglie di mettere queste note tra parentesi nel testo, cosa che rende lo scorrere delle parole ancora più difficoltoso per chi non è abituato.

Tuttavia è uno sforzo che vale la pena fare.

Perfetto, allora ti propongo una versione ampliata del paragrafo, che integra anche i concetti di infosfera, infraetica e responsabilità distribuita — elementi centrali del pensiero di Floridi e funzionali a comprendere l’impianto normativo e valoriale della sua proposta.

Perfetto, ecco il paragrafo rielaborato integralmente con l’inserimento del concetto di tecnologia general purpose, mantenendo lo stile informativo e coerente con i tuoi standard redazionali:

I concetti fondativi: re-ontologizzazione, agire intelligente e responsabilità distribuita

Alla base dell’etica dell’intelligenza artificiale formulata da Floridi vi è una riflessione filosofica strutturata su alcuni concetti fondamentali. Tra questi, spiccano la re-ontologizzazione della realtà, la distinzione tra intelligenza e agire intelligente, la nozione di infosfera, l’idea di infraetica e il principio di responsabilità distribuita. Meno importante, ma non marginale, è anche il riferimento alla natura dell’IA come tecnologia general purpose.

Con il termine re-ontologizzazione, Floridi descrive la trasformazione profonda e sistemica della realtà dovuta all’introduzione delle tecnologie digitali. In sostanza l’AI, e la tecnologia in generale, cambia la natura stessa della nostra realtà; quindi siamo noi, poi, che ci adattiamo a una realtà creata per accomodare le macchine. Una visione sconvolgente ma anche evidente, una volta che ci si riflette. Realizzare questo fatto è fondamentale se si vuole arrivare poi a una vera azione etica.

L’altro punto fondamentale messo sul tavolo da floridi è che l’AI è in grado di fare cose intelligenti senza essere davvero intelligente. Se certe azioni le facesse una persona, diremmo che per farle ha usato la propria intelligenza; per l’AI è quindi facile cadere nella trappola di pensare che sia intelligente, visto che fa cose intelligenti. Floridi quindi si prende qualche pagina per sottolineare questo aspetto.

La distinzione tra intelligenza e agire intelligente è centrale per evitare una visione fuorviante dell’IA. I sistemi automatizzati non comprendono, non riflettono, non hanno coscienza: agiscono come se fossero intelligenti, ma si tratta di comportamenti operativi, non cognitivi. Attribuire loro intenzionalità o soggettività morale è un errore concettuale che può portare a distorsioni normative, soprattutto in ambito penale e regolatorio.

Infosfera e onlife

Floridi riformula profondamente il nostro rapporto con l’ambiente informazionale introducendo il concetto di infosfera: non uno spazio virtuale separato dal mondo fisico, ma l’insieme integrato di tutte le entità e interazioni informazionali — siano esse biologiche, artificiali, umane o non umane. Nell’infosfera, ogni elemento può essere rappresentato, modificato, trasmesso e governato sotto forma di informazione. È in questo contesto che svanisce la distinzione tra online e offline: viviamo onlife, in una condizione in cui la nostra esistenza è strutturalmente intrecciata con quella dei sistemi digitali, e in cui le nostre azioni sono costantemente mediate da dispositivi, algoritmi, piattaforme.

Questa trasformazione impone un cambiamento anche nell’etica, che non può più essere solo reattiva o prescrittiva, ma deve diventare infrastrutturale. È il compito dell’infraetica: quell’insieme di regole implicite, standard tecnici, design delle interfacce, architetture informative e protocolli operativi che non impongono comportamenti morali, ma predispongono le condizioni affinché essi possano emergere, essere praticabili, comprensibili e non penalizzati. In questo senso, l’infosfera diventa anche il luogo in cui si costruiscono — o si impediscono — le possibilità dell’agire morale. E la responsabilità non sta solo nel giudicare cosa è giusto o sbagliato, ma nel progettare ambienti in cui il bene sia effettivamente accessibile.

Proprio per la complessità di questi ecosistemi, Floridi insiste sul concetto di responsabilità distribuita: le conseguenze delle decisioni algoritmiche non possono essere imputate a un solo attore. Dallo sviluppatore al data scientist, dall’ente pubblico che adotta la tecnologia all’utente finale, l’etica dell’IA richiede una cooperazione nella responsabilità, che deve essere condivisa, trasparente e documentabile. Lo scienziato invoca la creazione di un dibattito che sia il più ampio possibile, e che possa portare alla nascite di regole condivise da tutti; è lo spirito che ci ha portati, almeno in parte, all’AI Act Europeo.

Infine, seppur in modo meno esplicito, Floridi sottolinea la natura dell’intelligenza artificiale come tecnologia general purpose, cioè capace di essere impiegata in una vasta gamma di settori, spesso molto distanti tra loro. Questo la rende estremamente potente, ma anche altamente problematica dal punto di vista normativo, perché le stesse logiche computazionali possono generare effetti opposti a seconda del contesto: un algoritmo di raccomandazione può aiutare nella diagnosi medica o rafforzare la disinformazione politica. La sua apparente neutralità funzionale nasconde una profonda responsabilità etica nella fase di progettazione e nell’adattamento al contesto d’uso.

Sistemi morali e pazienti non umani

Nel quadro etico delineato da Floridi, la rilevanza morale di un agente non dipende dalla sua intelligenza o coscienza, ma dagli effetti che le sue azioni possono produrre all’interno dell’infosfera. È una prospettiva che rompe con la tradizione filosofica che lega l’etica alla razionalità del soggetto agente: non serve essere intelligenti per agire in modo moralmente rilevante, né per subire le conseguenze di un’azione. Quello che conta è la capacità di causare — o di essere oggetto di — effetti eticamente significativi.

Per questo, Floridi distingue tra agenti morali e pazienti morali. Gli agenti morali sono entità che compiono azioni con implicazioni etiche, mentre i pazienti morali sono coloro che subiscono tali azioni. In questa classificazione, anche sistemi non senzienti — come infrastrutture digitali, reti di IA, mercati finanziari automatizzati o ambienti sociali mediati da algoritmi — possono agire moralmente, nel senso che i loro effetti possono produrre danni o benefici tangibili per altri soggetti.

Allo stesso modo, anche soggetti non umani — come animali, ecosistemi, oppure identità digitali — possono essere pazienti morali, in quanto esposti a forme di sfruttamento, esclusione, discriminazione o danno sistemico.

Questa visione implica una profonda revisione del concetto di responsabilità. In un ecosistema digitale distribuito, gli effetti dannosi non sono sempre riconducibili a un singolo individuo colpevole. Possono essere il prodotto di un sistema opaco, di automatismi non monitorati, di bias strutturali nei dati o nel design. Per questo, Floridi sostiene che la responsabilità deve essere riconfigurata in modo collettivo e sistemico, e che vanno progettati meccanismi di compensazione, tutela e riparazione anche in assenza di un soggetto colpevole in senso classico.

Questa prospettiva è coerente con l’idea di etica infrastrutturale: non si tratta solo di valutare singoli atti o decisioni, ma di intervenire sui contesti, sugli ambienti e sui sistemi che permettono (o impediscono) l’azione etica. Un algoritmo non è “cattivo” in sé, ma può diventarlo se inserito in un contesto che ne amplifica i danni senza possibilità di controllo, contestazione o riparazione.

Progettare per il bene comune: dual use e AI for Social Good

La natura dell’intelligenza artificiale come tecnologia general purpose comporta un rischio strutturale: può essere impiegata per obiettivi benefici, ma anche per attività dannose, discriminatorie o illecite. È ciò che Floridi definisce dual use: la stessa architettura tecnica può sostenere sia pratiche virtuose sia forme di abuso. In questo contesto, la fase di progettazione diventa eticamente decisiva. Non è sufficiente intervenire a posteriori con regolamentazioni o sanzioni: è nel design iniziale che si decide se una tecnologia sarà compatibile con i valori sociali, politici ed ecologici che intendiamo promuovere.

Evitare la costruzione di sistemi dannosi significa, ad esempio, non normalizzare modelli linguistici che replicano stereotipi, non sviluppare social bot con caratteristiche etniche o di genere che simulano empatia, non alimentare infrastrutture che rendono opaca la filiera decisionale. Significa riconoscere che ogni scelta tecnica è anche una scelta etica, e che non esistono sistemi “neutrali”.

Questa impostazione trova espressione concreta nel concetto di AI for Social Good (AI4SG), una cornice operativa in cui l’IA è valutata non solo per la sua funzionalità tecnica, ma per la sua capacità di affrontare problemi reali, ridurre vulnerabilità, migliorare la qualità della vita e rispettare i limiti ecologici del pianeta. Un sistema è eticamente riuscito solo se riduce o elimina problemi senza generarne di nuovi. Il suo valore va misurato in termini di preferibilità sociale, equità concreta, sostenibilità ambientale, e non soltanto di efficienza computazionale.

In questa prospettiva si inseriscono iniziative come AI for Earth (Microsoft), AI for Social Good (Google) e il programma europeo Destinazione Terra, che impiega modelli digitali per simulare scenari climatici e valutare l’impatto delle politiche ambientali. In tutti questi casi, l’IA non è concepita come fine a sé stessa, ma come strumento di supporto a decisioni complesse, orientate al bene comune.

La sfida, per Floridi, non è sviluppare un’IA sempre più potente, ma un’IA socialmente sostenibile, politicamente legittima ed ecologicamente compatibile. E tutto inizia — o fallisce — nella fase di design.

Sette fattori per una IA socialmente buona

Luciano Floridi individua sette requisiti fondamentali che ogni sistema di intelligenza artificiale dovrebbe rispettare per essere considerato eticamente accettabile e socialmente valido. Questi criteri non rappresentano standard astratti, ma strumenti concreti per progettare tecnologie che siano allineate al benessere umano e ambientale.

-

Falsificabilità e miglioramento incrementale

I sistemi devono poter essere messi alla prova e migliorati nel tempo. La capacità di essere sottoposti a verifica è un requisito di responsabilità scientifica ed etica.

-

Protezione contro la manipolazione dei predittori

È necessario impedire che gli algoritmi predittivi vengano manipolati per ottenere vantaggi sleali, ingiusti o dannosi, ad esempio nei mercati finanziari o nelle campagne elettorali.

-

Contestualizzazione rispetto al destinatario

Le azioni dell’IA devono essere progettate tenendo conto del contesto in cui operano e delle caratteristiche specifiche dei soggetti coinvolti, evitando approcci standardizzati che ignorano le differenze individuali.

-

Finalità trasparenti e spiegabili

L’IA deve poter rendere comprensibili i propri scopi e comportamenti, in modo che gli utenti siano in grado di capire il “perché” delle sue decisioni.

-

Rispetto della privacy e consenso informato

Qualunque trattamento dei dati personali deve tutelare la riservatezza e basarsi su un consenso autentico e consapevole.

-

Equità concreta

L’equità non può essere solo teorica: i risultati dell’IA devono essere giusti e non discriminatori, soprattutto quando si applicano a categorie vulnerabili.

-

Adattabilità all’umano

L’IA deve essere progettata per funzionare in modo comprensibile, gestibile e coerente con le capacità cognitive delle persone, evitando soluzioni tecniche che creano esclusione o alienazione.

Floridi collega ciascuno di questi fattori a uno o più dei cinque principi etici generali — beneficenza, non maleficenza, giustizia, autonomia e spiegabilità — sottolineando l’importanza della coerenza tra design tecnico ed etica normativa.

Conclusioni

Nel libro di Floridi c’è molto di più di quanto ho raccontato in questo articolo, che ciò nonostante è venuto piuttosto corposo. È una lettura consigliata a tutti, e il cui studio dovrebbe essere obbligatorio almeno per alcune categorie professionali - in particolare chi si occupa di sviluppare AI e chi si occupa di regolamentazione.

Soprattutto però bisogna capire che realizzare un’AI etica significa comprendere che esiste nuova epistemologia e ontologia dei sistemi digitali. L’intelligenza artificiale ridefinisce il modo in cui abitiamo il mondo. Non possiamo limitarci a domande ingegneristiche: occorre ripensare le categorie fondamentali di agente, azione, responsabilità e verità. Solo così potremo sperare di evitare le molte trappole insite in questa tecnologia, e avere l’ardire di metterci - con l’AI - su un percorso virtuoso.

Stiamo già muovendo qualche primo passo nella direzione giusta, ed è lo stesso Floridi a ricordarci come l’AI sia uno strumento utile negli sforzi per contenere e rispondere al cambiamento climatico. Un fatto che - e non potrei essere più d’accordo - e il singolo problema più grande del genere umano al momento.

Ma ci stiamo muovendo anche sulla strada più pericolosa, con AI che producono o possono produrre disuguaglianze ancora più grandi rispetto a quelle che esistono ora.

Dobbiamo essere cauti e consapevoli per restare sul percorso giusto. E per ora, mi pare, non ce la stiamo cavando benissimo.

Questo commento è stato nascosto automaticamente. Vuoi comunque leggerlo?