Il Dell Technologies Forum è la conferenza tecnologica di punta di Dell, ideata per offrire una panoramica completa sui trend emergenti e sulle opportunità future.

Questo evento rappresenta un'occasione per esplorare come l’azienda voglia trasformare le proprie idee in innovazione, accelerando i progetti e passando rapidamente dal possibile al concreto.

Durante la conferenza di Milano, tenutasi pochi giorni fa, è stato possibile ascoltare gli interventi dei suoi leader aziendali. Tra questi c’era Frediano Lorenzin, Field Chief Technology Officer, il cui intervento si è aperto con alcune interessanti statistiche.

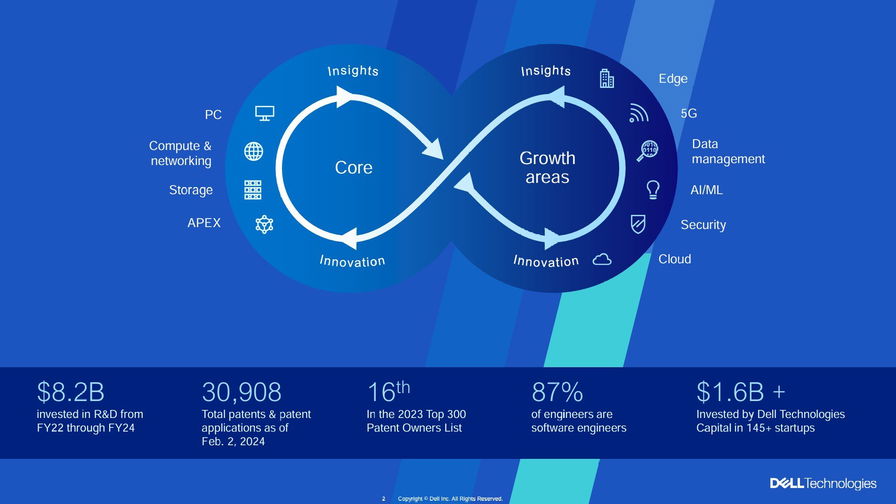

Dell ha investito 8,2 miliardi di dollari in ricerca e sviluppo tra l’anno fiscale 2022 e il 2024, con oltre 30.000 brevetti e domande di brevetto.

La maggior parte degli ingegneri Dell (87%) si occupa di sviluppo software, e la società ha investito oltre 1,6 miliardi di dollari in più di 145 startup tramite Dell Technologies Capital.

Dell considera l'intelligenza artificiale un'opportunità commerciale strategica, in linea con i trend emergenti. Il 57% delle organizzazioni globali è ancora agli stadi iniziali o intermedi nella loro evoluzione nell'AI generativa, mentre il 79% dei leader aziendali globali ritiene che l'AI migliorerà le capacità umane, portando a nuovi livelli di produttività.

L'importanza dei dati è particolarmente rilevante per le strategie di AI generativa: l'82% dei leader li considera come un fattore differenziante, e il 78% degli IT Decision Makers preferisce modelli on-premise o ibridi per garantire una gestione sicura e ottimizzata delle risorse.

Dell incoraggia un approccio focalizzato sulle persone e sull'importanza dei dati, ritenendo che questi siano essenziali per trasformare idee in innovazione e per mantenere un vantaggio competitivo.

La tavola rotonda

Successivamente abbiamo partecipato a una tavola rotonda con Frediano Lorenzin, e la prima domanda è partita proprio dalla centralità dell’IA nella conferenza di Dell.

Ossia: rispetto a un anno fa, dove già si parlava di intelligenza artificiale, quanto e come è stata adottata dalle aziende?

Lorenzin ha riposto sottolineando un’importante evoluzione: le aziende ora guardano all’intelligenza artificiale con una maggiore consapevolezza rispetto al passato.

Un anno fa, infatti, i clienti dimostravano spesso diffidenza e si informavano principalmente su casi d'uso generici.

Oggi, invece, i clienti sanno già cosa potrebbero ottenere dall’intelligenza artificiale e chiedono esempi concreti, come casi specifici già implementati, dimostrando interesse per soluzioni mirate alla loro realtà.

È un passaggio che rende il lavoro più fluido e complesso allo stesso tempo: da un lato si va incontro a una domanda più consapevole, dall’altro diventa necessario condividere esempi reali, raccontando i casi già sviluppati, soprattutto in Europa, e mostrando concretamente le applicazioni sul campo.

Lorenzin ha inoltre evidenziato un’altra trasformazione: mentre un anno fa si trattava spesso di progetti sperimentali, ora si osserva un numero crescente di aziende che portano questi use case in produzione, affrontando però sfide tecniche importanti.

Il passaggio dal testing, con pochi utenti e dati limitati, alla gestione su larga scala (ad esempio, con migliaia di utenti attivi 24 ore su 24 e con un volume elevato di dati), rappresenta un cambiamento radicale che richiede una vera rivoluzione nei modelli e nelle infrastrutture.

Come distinguersi in un mondo uniformato

Alla nostra domanda su come Dell voglia affermarsi grazie all'intelligenza artificiale quando essa è ormai il cavallo di battaglia di qualunque azienda, Lorenzin ha risposto che la differenza si trova nel raccontare esperienze concrete, confrontandosi con le sfide quotidiane e non con visioni future astratte.

Lungi dal delineare scenari ipotetici da qui ai prossimi cinque anni, ha detto di concentrarsi sui problemi reali delle aziende che stanno cercando di integrare l'IA in contesti operativi complessi, spesso ostacolati da architetture obsolete e infrastrutture legacy.

Lorenzin ha poi spiegato che una delle chiavi è trasferire esperienze pratiche da un cliente all'altro, personalizzandole. Portare esempi mirati, adattati a situazioni analoghe, rappresenta a suo dire un valore aggiunto.

Un esempio concreto riguarda una recente esperienza in cui una soluzione per la sicurezza sul lavoro – pensata per vigilare sull'uso corretto di caschi e altre attrezzature nei cantieri – è stata traslata e applicata in ambito sanitario, dimostrando come un’idea nata in un settore possa evolversi per rispondere alle esigenze di un altro.

Queste situazioni sottolineano il fatto che, pur avendo in molti i mezzi tecnologici – come server dotati di GPU o capacità di storage – non sempre hanno la competenza per utilizzarli al meglio.

A volte, un cliente può aver investito in soluzioni hardware senza avere una chiara strategia d'uso, ritrovandosi dopo un anno a richiedere supporto per reindirizzare il progetto.

Lorenzin ha concluso evidenziando il valore delle interazioni costanti con vari clienti: ogni esperienza arricchisce il bagaglio di conoscenze che può poi essere applicato altrove, costruendo un percorso di miglioramento continuo e condiviso.

Applicazioni concrete dell’IA in Italia

Alla richiesta di dati sugli use case di intelligenza artificiale sviluppati in Italia e sul loro grado di replicabilità, Lorenzin ha confermato che le grandi aziende sono tuttora i principali attori dell'adozione dell’intelligenza artificiale.

Ciò accade perché dispongono di capitali per sviluppare proof of concept (POC) anche complessi, testando sia l’IA generativa che soluzioni basate sull'analisi di dati tradizionale, come nei sistemi antifrode.

Tuttavia, l'adozione sta iniziando a coinvolgere anche le medie imprese, grazie alla riduzione dei costi tecnologici e alla possibilità di calibrare i modelli IA sui parametri specifici delle singole realtà, piuttosto che sui set di dati estesi usati in passato.

Lorenzin ha fatto riferimento agli sviluppi recenti con modelli linguistici più snelli, che costano meno e consentono di ottenere risultati con un investimento computazionale ridotto.

Molte aziende stanno inoltre puntando sull’inferencing e sul retrieval-augmented generation (RAG), che permettono di utilizzare modelli di base generici, personalizzandoli con dati aziendali specifici tramite prompting, senza bisogno di un lungo training su misura.

Per quanto riguarda gli use case concreti, Lorenzin ha indicato che, al momento, i progetti maggiormente scalabili si concentrano su funzioni di back office.

Questi sono infatti più semplici da implementare, offrono un ritorno sull’investimento (ROI) più facilmente misurabile e possono accelerare attività ripetitive e molto standardizzate, come la gestione documentale nei mutui o il risarcimento dei danni nelle assicurazioni.

Lorenzin ha quindi riconosciuto che i progetti mirati all’aumento dei ricavi sono meno comuni e più rischiosi, poiché i risultati restano incerti e richiedono maggiore convinzione da parte delle aziende per impegnarsi in investimenti significativi.

Interrogato su quanto i partner di canale stiano impegnandosi nell’adozione dell’intelligenza artificiale, Lorenzin ha raccontato che l’atteggiamento è alle volte di scetticismo di fronte all’ennesima proposta basata sull’intelligenza artificiale.

In tal caso, preferisce spostare rapidamente il focus ponendo l’accento su un approccio più pratico e collaborativo.

Invece di promuovere subito l’hardware, che pure rappresenta una parte importante dell’offerta, Lorenzin si concentra sull'aiutare i partner a capire cosa effettivamente intendono fare con l'IA.

Una volta chiariti questi obiettivi, l’infrastruttura necessaria diventa parte naturale della conversazione ma solo in una fase successiva, quando le priorità sono ben definite.

Grazie a questo approccio, i partner stanno effettivamente investendo in IA in modo significativo, segno che il supporto e il coinvolgimento congiunto sono utili a favorire una transizione più consapevole.

L’Edge Computing ai tempi dell’intelligenza artificiale

Meglio portare i dati all’IA o l’IA ai dati? Dietro questo apparente gioco di parole, si nasconde il discorso relativo all’Edge Computing, in merito al quale Lorenzin ha spiegato i vantaggi di creare e analizzare i dati direttamente nei luoghi in cui sono prodotti.

In casi come cantieri, fabbriche o strutture sanitarie, esso riduce la latenza, evita il rischio che i dati escano dalla struttura e riduce ovviamente i costi di trasferimento verso i data center o il cloud.

Esempi pratici sono il settore edilizio, in cui l’AI può intervenire in tempo reale per rilevare condizioni di sicurezza, come la presenza di operai senza casco.

Oppure l’healthcare, dove l’AI può assistere un chirurgo durante un intervento mostrando suggerimenti basati su immagini in tempo reale, senza necessità di trasferimenti di dati che rallenterebbero l’analisi.

Lorenzin ha anche osservato come l'integrazione tra IT e IoT si stia intensificando, richiedendo una fusione di tecnologie ICT con soluzioni AI distribuite direttamente nelle sedi operative.

Ciò consente di effettuare una prima analisi dei dati sul posto, rimandando solo in seguito le informazioni al centro per ulteriori elaborazioni di business intelligence.

La tutela dei dati però diventa un aspetto ancora più critico di quanto non lo sia già ora, ed è per questo motivo si sta diffondendo il federated learning, un approccio che permette di elaborare i dati localmente senza trasferirli, salvaguardando così la loro riservatezza.

In questo caso è l’IA che si sposta verso l’Edge, elaborando i dati sul posto e collegandosi solo saltuariamente coi server centrali.

Ciò vale anche per fabbriche e impianti industriali dove la sensoristica produce enormi quantità di dati: trasferirli sarebbe costoso e complesso, e l’Edge Computing risolve questa difficoltà elaborandoli in loco.

Infine, ha menzionato un caso interessante in corso a Las Vegas, dove un sistema di Edge Computing, è stato installato per gestire la sicurezza stradale e monitorare incidenti in tempo reale.

L'idea è quella di posizionare strategicamente piccoli data center nelle aree più sensibili, che possono crescere gradualmente: si parte da un numero limitato di punti di monitoraggio per estenderli successivamente, basandosi sull’efficacia dimostrata.

Questa flessibilità permette di ridurre i costi iniziali e di imparare progressivamente dall’uso dell'IA, migliorando le capacità di risposta e adattamento ai contesti locali.

On-prem, cloud ed edge

Dopo anni passati a spiegare l’importanza di spostare i dati dall’on-prem al cloud, non si corre il rischio di scoraggiare i clienti prospettandogli nuovi investimenti nell’Edge?

Per Lorenzin non si tratta di un problema in quanto il cambiamento è motivato da nuove esigenze di business e non da ripensamenti dell'IT.

Oggi infatti molte aziende stanno ripensando la propria strategia: non si tratta di un semplice ritorno on-premise (“repatriation”), ma di un approccio ibrido che combina cloud pubblico, cloud privato e risorse on-prem.

Secondo Lorenzin questa evoluzione spinge le aziende a pianificare con attenzione l’utilizzo dell’IA, valutando in anticipo se determinate applicazioni debbano essere gestite sul cloud o localmente e quali risorse siano necessarie per ottenere prestazioni adeguate.

Ha anche evidenziato che alcuni carichi di lavoro richiedono prestazioni elevate che possono essere ottenute solo on-premise, poiché i dischi e le infrastrutture cloud non sempre offrono il livello di performance richiesto.

Un altro aspetto cruciale riguarda il posizionamento e la qualità dei dati. La scelta su dove posizionare i dati, in base alla loro importanza e criticità, è la prima decisione da prendere; solo in un secondo momento si pianifica la potenza di calcolo necessaria.

Questo approccio richiede una maggiore flessibilità, perché una strategia interamente cloud od on-prem non è più sufficiente.

L’adozione di un modello multicloud e ibrido implica però una complessità crescente: i responsabili delle architetture IT si trovano oggi ad affrontare sfide considerevoli nel gestire dati e workload distribuiti tra Edge, on-premise e cloud.

C’è quindi oggi più che mai una certa difficoltà nel mantenere un’architettura coerente, nella quale i diversi ambienti devono coesistere e comunicare. Il che dimostra come il panorama tecnologico stia evolvendosi verso soluzioni flessibili e adattabili alle esigenze specifiche di ogni azienda.

La nuova moda: gli agenti AI

Immancabile poi un passaggio sugli agenti AI, il nuovo tormentone degli ultimi mesi, considerati dagli analisti il futuro della relazione tecnologica con l'utente.

Lorenzin ha espresso un notevole interesse, definendoli un’evoluzione dei chatbot tradizionali. Oggi, questi strumenti restano ancora percepiti come freddi e poco naturali nella comunicazione, ma l’obiettivo è renderli sempre più simili a interazioni umane autentiche.

Proseguendo il discorso sugli agenti AI, Lorenzin ha sottolineato come il vero salto in avanti dipenderà dalla fiducia che gli utenti saranno disposti a concedergli. Questo, nonostante in realtà la nostra società già oggi si affidi alla tecnologia più di quanto se ne renda conto.

Un esempio emblematico è quello del navigatore GPS, che ormai guida le persone anche lungo percorsi che conoscono bene. Dieci anni fa sarebbe sembrato impensabile, oggi invece è un gesto automatico delegare la guida al navigatore.

Lorenzin ha poi paragonato gli agenti AI ai suggeritori che troviamo nei marketplace o nei sistemi finanziari – come quelli sviluppati da IBM per suggerire investimenti – e ha fatto un parallelismo con i sistemi di guida autonoma.

L'aspetto tecnico, dunque, non differisce molto; ciò che manca ancora è un grado di fiducia che sia sufficiente per affidarsi a questi sistemi in modo più ampio e definitivo.

Mentre un errore nel navigatore può portare un semplice disagio, un errore in un investimento o in una decisione strategica può avere conseguenze ben più gravi e, in quel caso, la fiducia verrebbe irrimediabilmente compromessa.

La familiarità crescente e l’utilizzo quotidiano di queste tecnologie contribuiranno però a costruire questa fiducia gradualmente. In Europa l'adozione sarà più lenta rispetto ad altri mercati, soprattutto agli Stati Uniti, che tendono a sperimentare prima e a regolare dopo.

Da noi, invece, si procede spesso all’inverso, cercando prima di definire il quadro normativo e le verifiche necessarie per garantire sicurezza e trasparenza.

Anche gli agenti autonomi dovranno quindi essere inquadrati in un sistema regolamentare solido, che ne consenta un uso controllato e sicuro, un passo che Lorenzin ritiene inevitabile per il futuro.

Se lo dice l’IA…

Alla luce di quanto appena esposto, ci è venuto un dubbio: la crescente fiducia nelle tecnologie AI può influenzare il processo decisionale manageriale? Non si corre un rischio di de-responsabilizzazione della forza lavoro?

Lorenzin ha risposto affermando che sebbene l’IA offra suggerimenti e supporto, non dovrebbe mai prendere decisioni critiche in autonomia.

Ciò avviene, per esempio, in settori come la diagnostica per immagini in ambito sanitario, dove i sistemi AI forniscono solo un supporto per ulteriori opinioni, senza sostituire la valutazione umana.

In casi come questi, l’intelligenza artificiale può assistere il processo ma non prende decisioni indipendenti.

Piuttosto Lorenzin vede un rischio legato alla mancanza di familiarità con l'errore: chi è nato prima dell’era dell’IA, riconosce più facilmente le sue discrepanze. Al contrario, chi si è sempre affidato ai suggerimenti automatizzati, potrebbe non notarle.

A livello manageriale, affidarsi ciecamente all’IA rappresenterebbe un rischio. Sia perché gli errori avrebbero ripercussioni potenzialmente gravi, sia perché, cinicamente, il delegare tutto all’IA renderebbe i manager stessi superflui.

Lorenzin vede dunque un’adozione dell’IA più mirata, che si concentra su compiti specifici e ripetitivi, come la gestione dei problemi di base nel settore IT.

Qui, infatti, l'IA può rispondere autonomamente a segnalazioni semplici, e i sistemi di automazione possono correggere problemi comuni. Tuttavia, resta essenziale il monitoraggio umano, irrinunciabile in situazioni critiche.

In sintesi, Lorenzin prevede un futuro caratterizzato da una sinergia tra uomo e macchina, in cui l’IA supporterà i processi senza sostituire la supervisione e il giudizio umani, confermando che, anche in un’era dominata dalla tecnologia, il fattore umano resterà centrale nelle decisioni strategiche.