Nell'evento "Data Center and AI Technology Premiere" tenutosi oggi a San Francisco, in California, AMD ha annunciato i prodotti, la strategia e i partner del suo ecosistema dedicato a datacenter, supercomputer e cloud. La linea comune a tutta la presentazione è quella della riduzione del TCO (Total Cost of Ownership) dell’infrastruttura, garantendo comunque performance di alto livello.

Lisa Su, CEO di AMD, ha mostrato diversi chip soffermandosi continuamente sulle prestazioni offerte che sembrano incredibilmente migliori degli stessi EPYC di generazione precedente, sottolineando come la nuova gamma di prodotti punti a una ottimizzazione basata sulle specifiche del loro utilizzo. Per questo, abbiamo nuovi prodotti in diversi campi, strettamente legati ai carichi di lavoro che dovranno svolgere.

Iniziamo dal mercato forse più promettente: il cloud

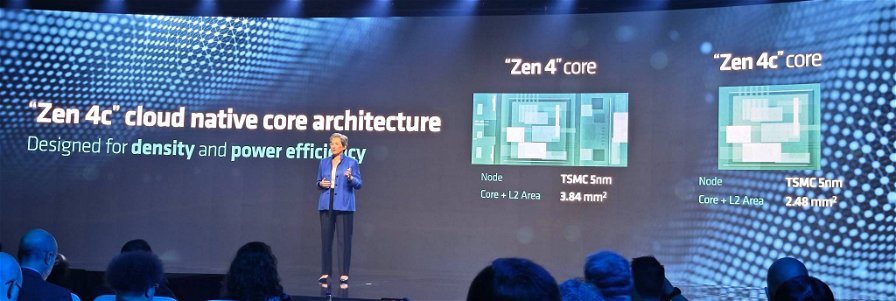

Per il calcolo nativo su cloud, un settore che è in rapida crescita e quindi molto allettante per il produttore di microchip, AMD ha introdotto i processori AMD EPYC 97X4 di quarta generazione, precedentemente noti con il nome in codice "Bergamo".

Con 128 core "Zen 4c" per socket, l’azienda sostiene di poter offrire la maggiore densità di vCPU sul mercato e prestazioni elevatissime per le applicazioni che vengono eseguite nel cloud, oltre a un'efficienza energetica fino a 2,7 volte superiore alla concorrenza pur supportando fino a 3 volte più container per ogni server. Buona parte di questa efficienza e forza bruta derivano dal processo produttivo a 5nm che dovrebbe essere alla base di una buona parte di ogni die.

Meta, dal canto suo, ha elogiato il produttore californiano per la costanza con la quale è riuscita a supportare la crescita dei suoi datacenter. Questo è un fattore da non sottovalutare: fornire tecnologia di alto livello non è abbastanza, bisogna farlo in maniera efficace e affidabile, in modo da supportare lo sviluppo e i progetti dei clienti.

Calcolo tecnico con una marcia in più grazie alla super cache

Per il settore dei supercomputer e dei carichi che richiedono elevata potenza di calcolo, AMD ha presentato i processori AMD EPYC di quarta generazione con tecnologia AMD 3D V-Cache (nome in codice “Genoa-X”). Con fino a 96 core "Zen 4" e una cache L3 da 1 GB, AMD posiziona questi EPYC come la scelta migliore per accelerare significativamente lo sviluppo dei prodotti, utilizzando meno server ed ottimizzando l'efficienza energetica.

Microsoft ha avallato la soluzione annunciandone l’uso nel suo cloud Azure, elogiando le performance che è riuscita a ottenere e il risparmio energetico di cui beneficia, mentre AWS è intervenuta per testimoniare il loro entusiasmo, sottolineando come l’offerta EC2 M7a, basata su “Genoa” garantisca performance migliori del 50% rispetto alla versione M6a.

Acceleratori dedicati all’IA, con un occhio di riguardo per quella generativa

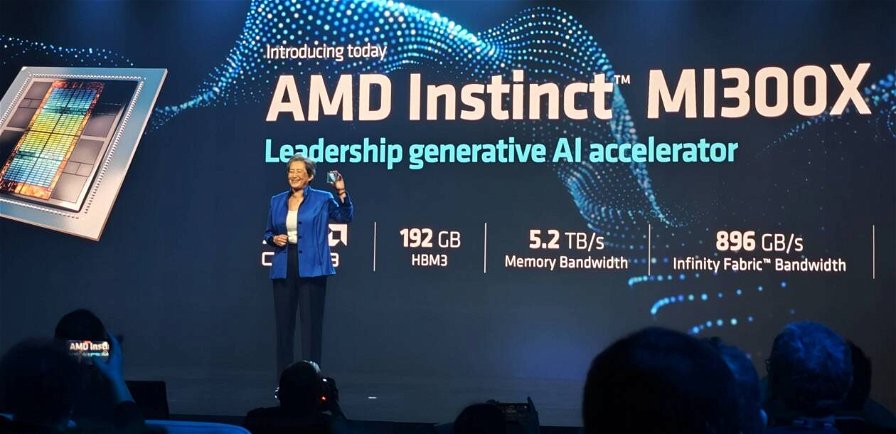

In un momento in cui l’IA generativa monopolizza i titoli delle sezioni tecnologiche di buona parte dei media non specializzati (e comunque quelli specializzati ne parlano ampiamente), AMD ha deciso di cogliere il momento e svelare i dettagli della famiglia di acceleratori AMD Instinct MI300.

Formata da soli due nuovi componenti, l’AMD Instinct MI300X si distingue per esser presentato come l'acceleratore più avanzato al mondo per l'intelligenza artificiale generativa. Basato sull'architettura AMD CDNA 3 di prossima generazione e con un supporto nativo alla memoria HBM3 fino a 192GB, fornisce l'efficienza di calcolo e memoria necessaria per l'inferenza di modelli di linguaggio di grandi dimensioni e per i carichi di lavoro di intelligenza artificiale generativa.

Grazie al supporto di una tale quantità di memoria, l’AMD Instinct MI300X permette di eseguire modelli di linguaggio di grandi dimensioni come Falcon-40B, un modello con 40 miliardi di parametri, su un singolo acceleratore GPU MI300X tenendolo tutto in memoria. Il MI300X verrà fornito in campione a clienti chiave a partire dal terzo trimestre.

AMD ha inoltre annunciato che l'AMD Instinct MI300A, il primo acceleratore APU al mondo per carichi di lavoro di HPC e AI che è ora in fase di campionamento per i clienti. In questo caso si tratta di una APU che fonde insieme 13 chiplets, alcuni dei quali 3D, per creare un singolo prodotto con 24 core Zen4 fusi con un motore grafico CDNA3 e 128GB di memoria HBM3 divisa in 8 blocchi.

In tutto, questo notevole pezzo di silicio vanta 146 miliardi di transistor realizzati con tecnologia a 5 e 6 nanometri ed è destinato a partecipare al progetto del supercomputer El Capitan, il computer più potente del mondo che dovrebbe diventare operativo più tardi quest’anno.

L’hardware è importante, ma la magia è nel software (cit.)

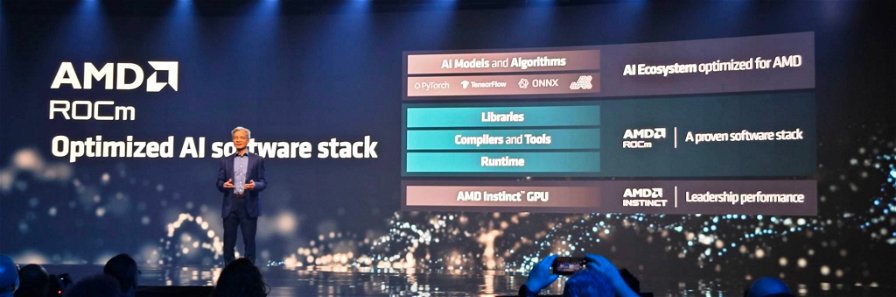

Giunti alla presentazione di ROCm, appare chiaro che AMD ha imparato la lezione impartita dal saggio Bill Gates e si sta impegnando molto nella creazione di un ecosistema software aperto, affidabile e quanto più diffuso possibile per spingere gli usi della sua line-up di prodotti dedicata all’IA.

ROCm è una piattaforma software che permette agli sviluppatori di sfruttare con grande facilità la potenza degli acceleratori Instinct. PyTorch ne ha elogiato le funzionalità e le performance che permette di ottenere direttamente dal palco, dando una bella mano alla sua immagine.

“Pensado” alla rete e alla virtualizzazione…

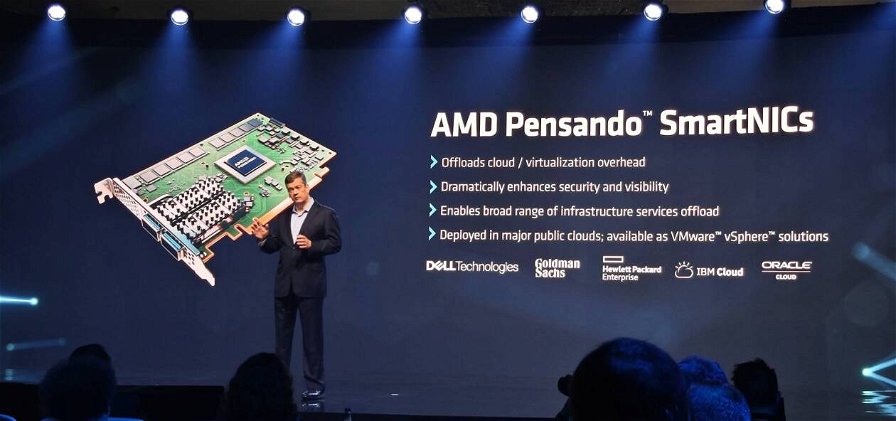

AMD ha anche mostrato un robusto portafoglio di soluzioni di rete per il cloud e le aziende, tra cui l'AMD Pensando DPU, le schede di rete a bassa latenza AMD Ultra e la scheda di rete adattativa AMD. I DPUs Pensando di AMD combinano una solida pila software con un solido strato di sicurezza e un processore all'avanguardia per creare un DPU (Data Processing Unit) estremamente potente e competitiva.

Entro la fine del 2023 arriverà la nuova generazione che mira a offrire prestazioni e efficienza energetica superiori rispetto ai prodotti della generazione attuale.

AMD ha inoltre annunciato l'AMD Pensando Software-in-Silicon Developer Kit (SSDK), che consente ai clienti di sviluppare o migrare rapidamente servizi da implementare sull'AMD Pensando P4 programmable DPU in collaborazione con l'ampio set di funzionalità già implementate sulla piattaforma Pensando. L'AMD Pensando SSDK consente ai clienti di sfruttare il potere dell'AMD Pensando DPU di punta e personalizzare le funzionalità di virtualizzazione e sicurezza di rete all'interno della propria infrastruttura, in coordinamento con l'ampio set di funzionalità già implementate sulla piattaforma Pensando.