I video falsi diventeranno ancora più realistici con le scansioni a corpo intero. Come se non bastassero le preoccupazioni riguardo la falsificazione dei volti, infatti, stanno cominciano a farsi strada i deepfake a corpo intero.

L'approccio è lo stesso: usare algoritmi di AI per sostituire una persona con un'altra (ci sono famosi esempi con Barack Obama o Donald Trump). La novità, pubblicata anche su GitHub, è appunto l'estensione all'intero corpo umano.

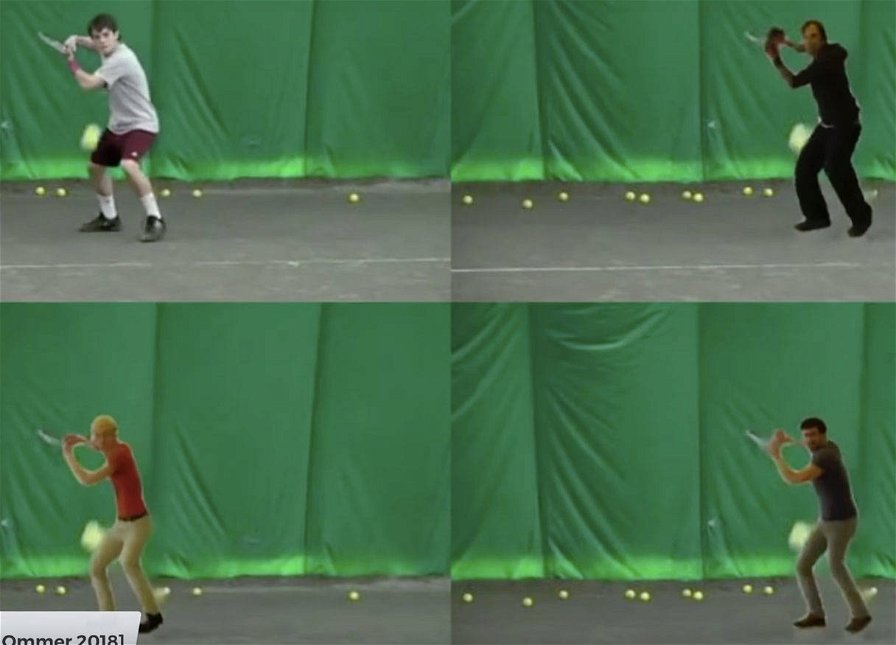

Al momento i risultati sono piuttosto grossolani, ma lo erano anche i primi esperimenti con i volti. Questi ultimi in pochi mesi hanno raggiunto un livello così alto di realismo che la maggior parte delle persone non è in grado di distinguere un video artefatto da uno autentico. E lo stesso accadrà con i video a corpo intero.

I creatori del nuovo algoritmo guardano con entusiasmo all'applicazione di questa tecnologia all'intrattenimento, in particolare i videogiochi o i film di animazione. Sono senz'altro due campi che potrebbero giovare molto da questi algoritmi.

La novità ha anche un possibile uso ludico; chi non si divertirebbe mostrandosi ai suoi amici nel compiere azioni ai limiti dell'umano, come camminare sui lego a piedi nudi (le braci ardenti sono demodé), battere in velocità un podista titolato o qualsiasi altra cosa vi venga in mente.

Oggi è già possibile fare qualcosa di simile: ammesso e non concesso che abbiate abbastanza foto del vostro viso, potete sostituirvi a un campione, diciamo Roger Federer, durante un set o un'intera partita. I movimenti restano i suoi, ma la faccia sarà la vostra. Con i nuovi algoritmi potrete invece rendere i movimenti coerenti con il vostro stile, modificarli ed eventualmente rivedere l'abbigliamento. Renderebbe il video ancora più credibile, e lascereste tutti a bocca aperta. Fantastico, no?

Meno divertente sarebbe vedere il proprio atleta preferito commettere una brutta scorrettezza, o un leader politico fare qualche gesto imbarazzante e inadeguato. Gesti che saranno accompagnati da una mimica facciale credibile, ed eventualmente da dialoghi. Diciamo che domani salta fuori un video in cui un capo di governo complotta con un criminale o riceve mazzette; e diciamo che nessuno è in grado di smentire immediatamente quel video. L'analisi tecnica restituirà l'onore e la reputazione al politico, ma il danno sarà irrimediabile. Non ci sarà bisogno di un ricatto come nel primo episodio della prima stagione Black Mirror: basteranno un computer e un po' di tempo.

Certo, non esiste tecnologia di cui non si possa abusare, questo ormai lo abbiamo imparato. Ma esserne consapevoli non è di grande aiuto, soprattutto se si considera il fatto che le possibili conseguenze di un abuso non fanno che crescere in gravità. Una ventina di anni fa scenari come questi sarebbero stati pura fantascienza, e di fronte a cambiamenti così rapidi è lecito domandarsi se siamo pronti ad affrontarli. Che cosa ne pensate?

Quando si parla di Black Mirror c'è sempre qualcuno che ancora non l'ha visto. Recuperare è doveroso